Modele klimatu – czym są? Jak działają? Do czego można je wykorzystać? Czym różnią się od modeli pogody? Czytaj w naszym wprowadzeniu!

„Cała teoria globalnego ocieplenia opiera się na modelach matematycznych”, „Śmieci na wejściu, śmieci na wyjściu”… te i podobne zdania dyskredytujące klimatologię i numeryczne modelowanie zjawisk atmosferycznych często padają w dyskusjach na temat klimatu. Zwykle wynikają po prostu z niewiedzy. Nawet osoby znające się na programowaniu, ale nie mające doświadczeń z numerycznym modelowaniem zjawisk fizycznych, albo mające takie doświadczenia, lecz nie w dziedzinie nauk o Ziemi, nie zawsze zdają sobie sprawę z tego, na czym polega i jaka jest specyfika modelowania klimatu… i że jeśli ktoś wkłada do modeli „śmieci”, to specjalnie, by je przetestować.

Równania, nie „wymysły”

Zacząć trzeba od tego, że numeryczne modele klimatu (oraz pogody) nie bazują na niczyich „wymysłach” czy „wyobrażeniach”. Modele to tak naprawdę układy równań. Podstawowe to równania ruchu atmosfery wynikające z zasad dynamiki Newtona (tak, tak – tych, o których uczymy się w szkole). Opisują one, jakie siły działają na każdą analizowaną porcję powietrza (tzw. cząstkę). Przede wszystkim jest to siła wywoływana przez różnice ciśnienia, a poza tym siły bezwładności (Coriolisa, odśrodkowa), siła grawitacji i siły tarcia (o podłoże i o sąsiednie cząstki powietrza). Równania ruchu uzupełnia się związkami mówiącymi o zachowaniu energii, ciągłości ośrodka (w powietrzu nie ma „dziur”), przemianach fazowych itd. W przypadku modeli klimatu zasadnicze znaczenie ma tzw. równanie transferu promieniowania, czyli opis przechodzenia (a także pochłaniania, emitowania czy rozpraszania) promieniowania przez atmosferę.

Warto podkreślić, że są to dobrze znane, wielokrotnie sprawdzone prawa fizyczne, które wykorzystuje się w rozmaitych dziedzinach – choćby konstruowaniu samolotów.

Świat w siatce

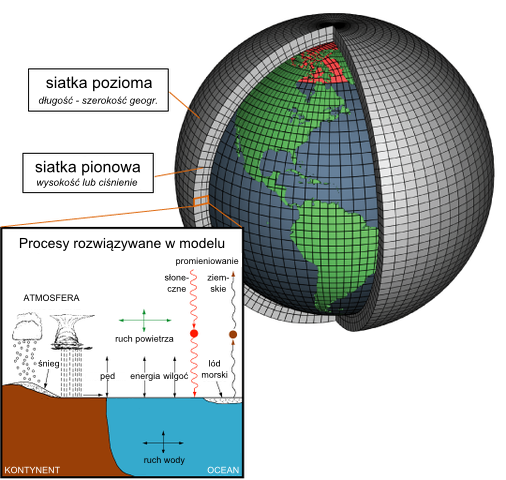

Oczywiście nie jest możliwe, by za pomocą nawet superkomputera odtworzyć ruch poszczególnych molekuł powietrza. W rzeczywistości symuluje się ruch dość dużych objętości powietrza, a równania rozwiązuje dla wybranych, najczęściej regularnie rozłożonych punktów – tzw. węzłów siatki obliczeniowej. Wynikiem obliczeń są więc informacje o temperaturze, ciśnieniu powietrza, prędkości wiatru itd. w tych konkretnych punktach. W każdym punkcie zależą one od tego, co działo się w poprzednim kroku czasowym oraz co działo się u jego sąsiadów. Przyjmuje się, że wartości węzłach są reprezentatywne dla otaczającego ich obszaru – tzw. oczku siatki.

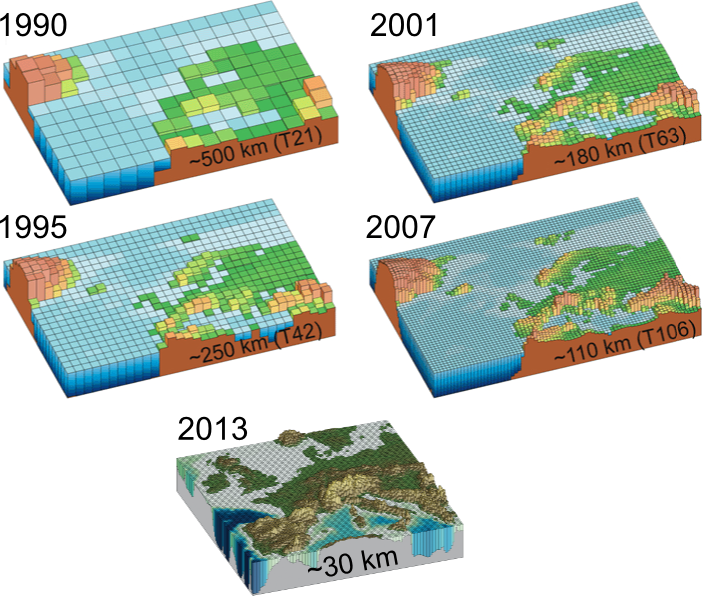

Siatka modelu zazwyczaj przypomina właśnie siatkę z prostokątnymi lub trójkątnymi oczkami. Upraszczając, im gęstsza siatka, tym obliczenia dokładniejsze – ale i dłuższe. W zależności od tego, czy analizujemy pogodę w skali globalnej, regionalnej czy lokalnej, możemy pozwolić sobie na różną gęstość siatki. W modelu globalnym węzły siatki oddalone są od siebie o kilkadziesiąt kilometrów, a przykładowo modele stosowane do obliczania prognoz pogody dla Europy Środkowej przez Interyscyplinarne Centrum Modelowania Matematycznego i Komputerowego uruchamiane są na gęstych siatkach: czterokilometrowej (model UM) i trzynastokilometrowej (model COAMPS). Chodzi bowiem o to, by jak najlepiej oddać w prognozie przestrzenne zróżnicowanie zjawisk – słowem, czy po naszej stronie rzeki deszcz spadnie czy nie.

Również w modelowaniu klimatu im gęstsza siatka, tym lepiej scharakteryzowana przestrzenna zmienność zjawisk i klimat lokalny. Rysunek 1 pokazuje postęp, jaki nastąpił pod tym względem pomiędzy pierwszym a najnowszym raportem IPCC.

Na razie zajmowaliśmy się siatką poziomą, a co dzieje się w pionie? Większość zjawisk, jakie interesują nas w przypadku modelowania pogody, zachodzi poniżej wysokości 20 kilometrów. Żeby więc odtworzyć je w rzeczywistości wirtualnej, musimy rozmieścić punkty w pionie ciaśniej niż w poziomie. Dość typowym rozwiązaniem jest większa gęstość siatki przy powierzchni Ziemi (gdzie zachodzi dużo ważnych zjawisk i można na przykład zlokalizować wysokość podstawy chmur) i mniejsza wysoko w atmosferze, gdzie powietrze jest rozrzedzone i sytuacja na różnych wysokościach jest mniej zróżnicowana. Nowoczesne modele mają typowo ok. 30-50 poziomów i obejmują 30-40 kilometrów w pionie.

Między oczkami

No dobrze, wiemy już, że obliczenia dają nam wartości parametrów atmosfery w konkretnych punktach, pomiędzy którymi może być kilka, kilkadziesiąt a nawet kilkaset kilometrów odległości. Tymczasem z naszego codziennego doświadczenia wynika, że są zjawiska meteorologiczne o dużo mniejszym zasięgu. Zdarza się przecież, że deszcz pada w jednej dzielnicy miasta, a w drugiej nie, że chmury powstają tylko nad wąskim pasem przybrzeżnym, gdy nad morzem niebo jest czyste itd. Te zjawiska są jak drobne rybki, które przemykają przez grube oczka siatki – model nie jest w stanie ich dokładnie opisać. Co z nimi począć? Oczywiście jest na to sposób. Takie zjawiska opisuje się nie ściśle, ale w sposób przybliżony. Mówimy o „parametryzacjach” tzw. „procesów podskalowych”. Parametryzacje to związki ustalone i sprawdzone doświadczalnie, a mówiące np. ile jakich chmur powstaje przeciętnie przy konkretnej temperaturze, wilgotności, prędkości wiatru itd.

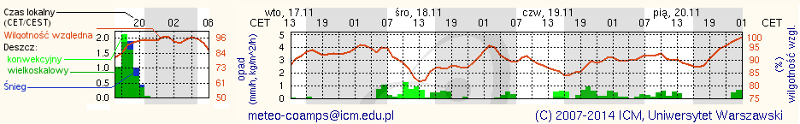

Na podobnej zasadzie są one następnie reprezentowane w prognozie pogody. Jeśli zobaczymy w meteorogramie zapowiedź „opadu konwekcyjnego” (chmury konwekcyjne miewają średnice rzędu kilku – kilkunastu kilometrów, więc nie ma szans na prześledzenie pojedynczych chmur w modelu), to wiemy, że intensywny deszcz spadnie gdzieś w promieniu kilkunastu kilometrów od nas, ale może nas też ominąć. Jeśli opad ma być „wielkoskalowy”, to znaczy, że związany będzie z wielką strefą zachmurzenia, którego losy łatwo odtworzyć w modelu i zlewa raczej nas nie ominie.

Poprawność parametryzacji i modeli numerycznych weryfikuje się, porównując wyniki symulacji z wynikami pomiarów, a w szczególności kampanii pomiarowych. Kampaniami pomiarowymi nazywa się zmasowane pomiary, w których najczęściej bierze udział przynajmniej kilka instytucji badawczych i w których wykorzystuje się jednocześnie wiele przyrządów pomiarowych. Przykładem małej kampanii pomiarowej może być projekt Physics of Stratocumulus Top – POST, w którym za pomocą samolotu badawczego i danych satelitarnych badano procesy na górnej granicy chmur stratcocumulus po to żeby poprawić ich parametryzację w modelach pogody i klimatu. Dużą kampanią pomiarową był również projekt DYNAMO, w którym badano oddziaływanie atmosfera-ocean i głęboką konwekcję w tropikach, a w pomiarach brały udział 3 statki badawcze, samoloty, satelity, specjalne autonomiczne roboty pomiarowe i kilkadziesiąt ekip badawczych z kilkunastu krajów.

Modele pogody a modele klimatu

Jak pisaliśmy wyżej, modele klimatu i modele pogody opierają się na tych samych podstawowych prawach. Jaka jest między nimi różnica i dlaczego w prognozowaniu klimatu nie przeszkadza teoria chaosu?

Sekret kryje się w tym, jakie dodatkowe warunki narzucamy naszym równaniom.

W przypadku prognozy pogody zakładamy, że takie rzeczy jak ilość docierającego do Ziemi promieniowania słonecznego, zawartość energii w oceanie czy koncentracja dwutlenku węgla w powietrzu nie zmieniają się znacząco z dnia na dzień. Oczywiście robimy tak nie dlatego, że „tak nam się wydaje”, tylko dlatego, że zostało to sprawdzone i w krótkich okresach czasu (interesujących nas przy przygotowywaniu prognozy pogody na najbliższe dni) jest to wystarczająco dobre przybliżenie. Do modelu pogody wprowadzamy wyniki pomiarów przeprowadzonych na całym świecie w konkretnym terminie, a model oblicza, co stanie się w ciągu kilku najbliższych dni – dokąd powędrują poszczególne masy powietrza, gdzie spadnie deszcz itd. Wynik silnie zależy od wprowadzonych danych pomiarowych, a niewielkie ich zmiany prowadzić mogą do sporych zmian w symulowanej pogodzie. Dlatego problem prognozy pogody nazywamy „problemem warunków początkowych”.

W przypadku prognozy klimatu rzecz ma się nieco inaczej. Tu nie interesuje nas, czy 30 listopada 2030 o 15:00 będzie padać czy nie i nie oczekujemy, że model prawidłowo określi takie szczegóły. Pytamy, jakie warunki będą panować średnio rzecz biorąc w listopadach 2025-2030. To, jakie warunki początkowe wprowadzimy do takiej symulacji, traci na znaczeniu. Na pierwszy plan wysuwają się natomiast tak zwane warunki brzegowe, czyli na przykład pomijane w prognozie pogody zmiany koncentracji dwutlenku węgla (czytaj więcej Globalne ocieplenie: wersja dla niewtajemniczonych). Problem prognozy klimatu nazywamy więc „problemem warunków brzegowych” – sprawdzamy, jak zmieniają się klimatyczne statystyki w odpowiedzi na ich zmiany.

Co wkładamy, co wyjmujemy, a co jest w środku

Wzór łączący prędkość, drogę i czas można wykorzystać zarówno do obliczenia jak długo potrwa podróż z miasta A do miasta B jak i oszacowania, jak daleko da się zajechać w ciągu godziny. Podobnie model klimatu można wykorzystać zarówno do obliczenia, jak zmieni się średnia temperatura w odpowiedzi na podwojenie koncentracji dwutlenku węgla czy innych gazów cieplarnianych, ale też o ile musi się zwiększyć koncentracja CO2, by temperatura wzrosła o dwa stopnie. Naukowcy konfigurują obliczenia w najrozmaitszy sposób, by uzyskać odpowiedź na różne pytania (Czy ocieplenie powyżej progu 2 stopni Celsjusza jest nieuchronne?, Chmury, klimat i przyśpieszony wzrost temperatur). Być może stąd biorą się nieporozumienia na temat tego, co się do modeli klimatu wprowadza, a co otrzymuje jako wynik symulacji. Skoncentrujmy się jednak na tym, co najczęściej trafia do publiczności, czyli projekcjach klimatu takich jak te przedstawiane w raporcie IPCC.

Jak wspomnieliśmy już na początku, w modelu opisane jest, jak działa system klimatyczny Ziemi. Jakie związki łączą ruch w atmosferze i oceanie, przepływy energii, pędu, materii, obieg węgla i innych ważnych pierwiastków i związków w przyrodzie itd. Siłą rzeczy, model uwzględnia takie zjawiska jak cyrkulacja oceaniczna (czytaj więcej Mit: Zmiany klimatu są powodowane zmianami prądów morskich) czy zmiany albedo w związku np. ze zmianą zasięgu lodu morskiego (czytaj więcej Arktyczne wzmocnienie).

Podkreślmy: przy obliczaniu projekcji klimatu modelowi nie „mówi się”, jaka jest czułość klimatu, czyli o ile średnia temperatura powierzchni Ziemi ma się zmienić w odpowiedzi na zmianę koncentracji dwutlenku węgla. To jest właśnie to, co się z użyciem modelu oblicza.

Przy obliczaniu prognozy klimatu na 100-300 lat do przodu nie ma potrzeby uwzględniania zmian orbitalnych Ziemi (czytaj więcej: Klimat: przeszłość, teraźniejszość, przyszłość), bo w tym czasie ich faza nie zmienia się znacząco (np. Kutzbach i Guetter, 1986). W ramach eksperymentów sprawdza się też wpływ zmian aktywności słonecznej, które również okazują się mieć niewielkie znaczenie (czytaj więcej Pojutrze. Mit wiecznie żywy). Nie da się na razie przewidzieć takich zdarzeń jak erupcje wulkaniczne albo wojna nuklearna, ale prowadzi się eksperymenty numeryczne na temat „co by było gdyby” (np. Przed czym uchronił nas Protokół Montrealski?, Mit: Nadchodzi globalne ochłodzenie, Jak wpłynęłaby na klimat wojna nuklearna).

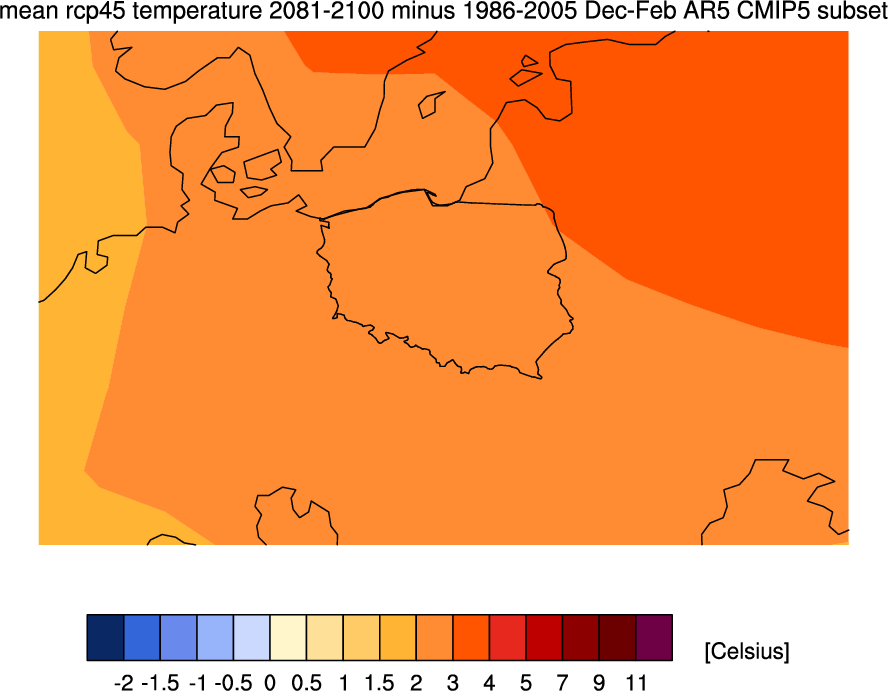

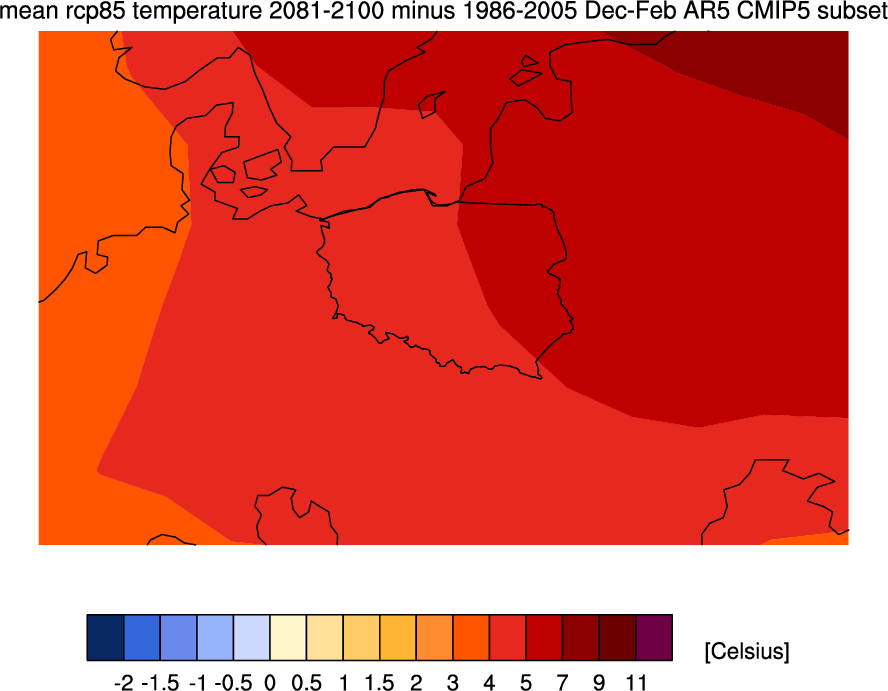

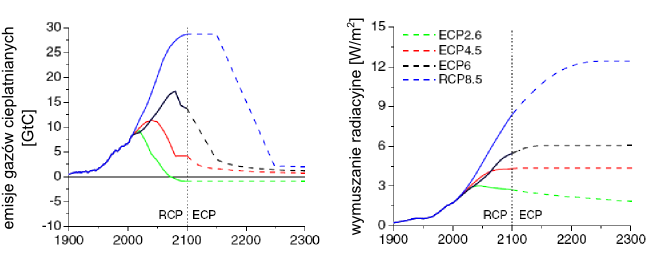

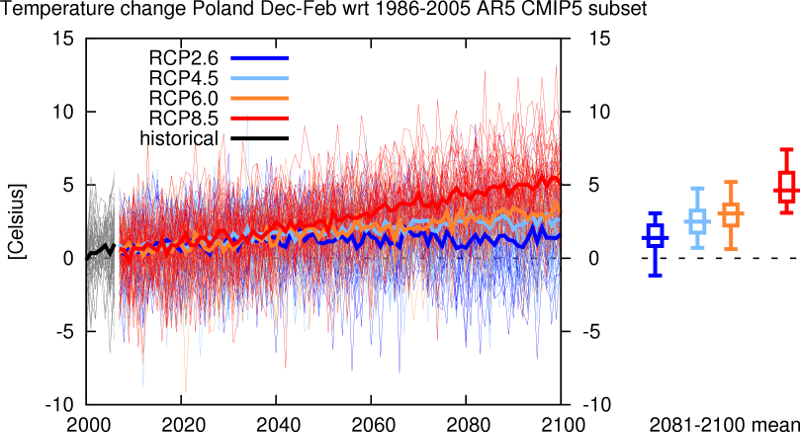

„Co by było gdyby” to zresztą zasadnicze pytanie, jakie przyświeca prognozowaniu klimatu. Ściśle rzecz biorąc nie wiemy przecież, jakie decyzje podejmą rządy całego świata w kwestii ograniczenia emisji i jakie to będzie miało przełożenie na gospodarkę. Dlatego projekcje klimatu przygotowuje się w kilku wariantach. Obecnie standardem jest wykorzystanie scenariuszy przyszłych emisji zwanych Representative Concentration Pathways (sporo na ten temat piszemy w tekście Dodatkowe emisje ze źródeł naturalnych a przyszła zmiana klimatu). Nikt nie spodziewa się, że którykolwiek z nich zostanie zrealizowany co do joty, ale można oczekiwać, że jeśli powędrujemy np. pomiędzy ścieżką RCP4.5 a RCP6.0 to skutki dla klimatu będą również pośrednie pomiędzy symulacjami 4.5 oraz 6.0.

Podsumowując, modele klimatu to złożone programy komputerowe, w których naukowcy zamykają całą swoją wiedzę o działaniu systemu klimatycznego Ziemi. Programy te obliczają, jak zmieniają się statystyki klimatyczne – średnie wartości temperatur, opadów, temperatury minimalne i maksymalne, liczby dni z mrozem, opadami, upałami itd. Korzystają przy tym z praw fizyki, chemii i sprawdzonych empirycznie związków statystycznych, wyników pomiarów i obserwacji biosfery, hydrosfery, kriosfery, litosfery i atmosfery. Przed wykorzystaniem modelu do obliczania projekcji klimatu testuje się go na danych historycznych. Projekcje klimatu nie mówią nam, co się wydarzy, tylko co może się wydarzyć przy założeniu takich czy innych scenariuszy. Na razie wyniki modelowania klimatu sprawdzają się całkiem dobrze – patrz Mit: Przewidywania Jamesa Hansena z 1988 roku były błędne.

Zainteresowanym tematem polecamy dodatkowo krótkie wystąpienie dr Gavina Schmidta z NASA (są polskie napisy).

Aleksandra Kardaś, konsultacja merytoryczna: prof. Szymon Malinowski.

Fajnie, że tu jesteś. Mamy nadzieję, że nasz artykuł pomógł Ci poszerzyć lub ugruntować wiedzę.

Nie wiem, czy wiesz, ale naukaoklimacie.pl to projekt non-profit. Tworzymy go my, czyli ludzie, którzy chcą dzielić się wiedzą i pomagać w zrozumieniu zmian klimatu. Taki projekt to dla nas duża radość i satysfakcja. Ale też regularne koszty. Jeśli chcesz pomóc w utrzymaniu i rozwoju strony, przekaż nam darowiznę w dowolnej wysokości