STANOWISKO NAUKI

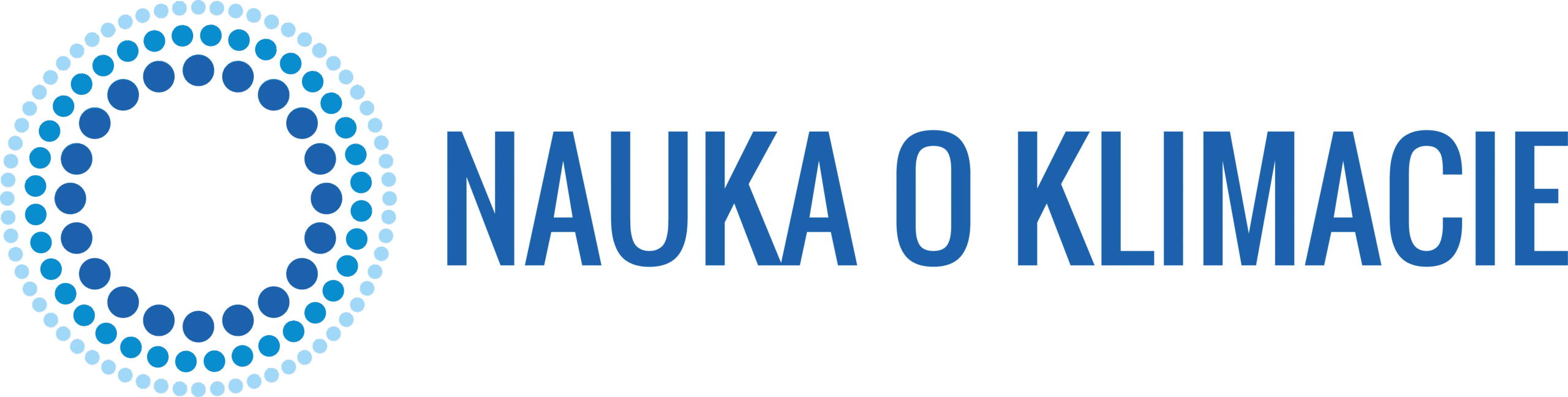

Model Hansena z 1988 roku nadzwyczaj dokładnie przewidział wzrost temperatury. Analizując prognozę Hansena, należy skupić się na Scenariuszu C, który najlepiej odpowiada rzeczywistym zmianom wymuszania radiacyjnego. Zgodność obserwowanej temperatury z prognozą sprzed ponad ćwierć wieku jest bardzo wysoka. Również przewidywane zmiany wymuszania radiacyjnego, geograficznej charakterystyki ocieplenia oraz częstotliwości fal upałów zostały potwierdzone obserwacyjnie.

MIT

Przewidywania Jamesa Hansena z 1988 roku były błędne

„23 czerwca 1988 James Hansen, naukowiec NASA, oświadczył w Izbie Reprezentantów, że jest silne „powiązanie przyczynowo-skutkowe” pomiędzy obserwowanymi temperaturami, a ludzkimi emisjami gazów cieplarnianych do atmosfery. W tym czasie Hansen przedstawił też model przyszłego zachowania temperatury globu, który zawarł w materiale wideo, intensywnie propagowanym w Kongresie. Model przewidywał, że w okresie 1988-1997 temperatura wzrośnie o 0,45°C (rysunek 1). Naziemne pomiary IPCC pokazują wzrost o 0,11°C, czyli czterokrotnie mniejszy, niż przewidywany przez Hansena. Prognoza z 1988 roku była spektakularną klapą. IPCC, które w 1990 uznało przewidywania Hansena za realistyczne, zwyczajnie było w błędzie.” (Pat Michaels)

W 1988 roku James Hansen przedstawił prognozę wzrostu średniej temperatury powierzchni Ziemi w trzech scenariuszach A, B i C. Scenariusz A zakładał dalszy wykładniczy wzrost emisji gazów cieplarnianych. Scenariusz B zakładał wolniejszy, liniowy wzrost emisji, a Scenariusz C – ich szybki spadek od roku 2000 (Hansen 1988). Hansen przeliczył emisje na zmiany koncentracji gazów w atmosferze i dalej na wymuszanie radiacyjne. Na tej podstawie przygotował prognozę zmiany temperatury.

Rzeczywiste emisje dwutlenku węgla były zbliżone do tych ze Scenariusza A, jednak, jak widzimy na rysunku poniżej, rzeczywisty wzrost temperatury był mniejszy od prognozowanego przez Hansena.

Jak podsumował to sceptyk John Christy, „stary [model globalnego klimatu] NASA był znacznie bardziej czuły na gazy cieplarniane, niż prawdziwa atmosfera.” Niestety, dr Christy nie dopowiedział, dlaczego tak było i jakie z tego można wyciągnąć wnioski.

Nie tylko dwutlenek węgla

Czy skoro emisje CO2 były zbliżone do tych ze Scenariusza A, a wzrost temperatury odpowiadał Scenariuszowi C to znaczy, że „stary [model globalnego klimatu] NASA był znacznie bardziej czuły na gazy cieplarniane, niż prawdziwa atmosfera”?

Bynajmniej. Globalna temperatura powierzchni zależy nie tylko od emisji dwutlenku węgla, lecz od wielu innych czynników wpływających na równowagę radiacyjną planety.

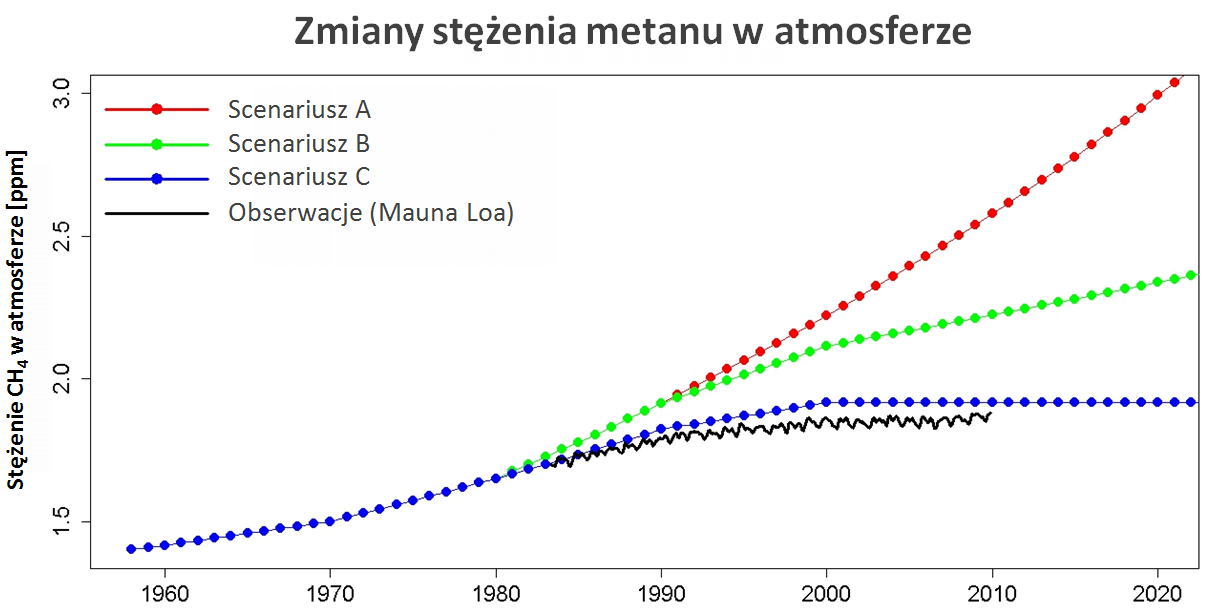

Nawet wśród gazów cieplarnianych CO2 nie jest jedynym czynnikiem wpływającym na bilans radiacyjny planety. Mamy też metan (CH4), NO2 i szereg innych gazów. Są również aerozole, o wpływie chłodzącym netto. Jak zmiany tych wszystkich czynników mają się do scenariuszy z prognozy Hansena z 1988 roku? Zacznijmy od zmian stężenia metanu:

Okazuje się, że stężenie metanu (i jego wymuszanie radiacyjne) rosło nawet wolniej niż w Scenariuszu C. Również emisje freonów, w rezultacie wdrożenia postanowień Protokołu Montrealskiego, były mniejsze od prognozowanych.

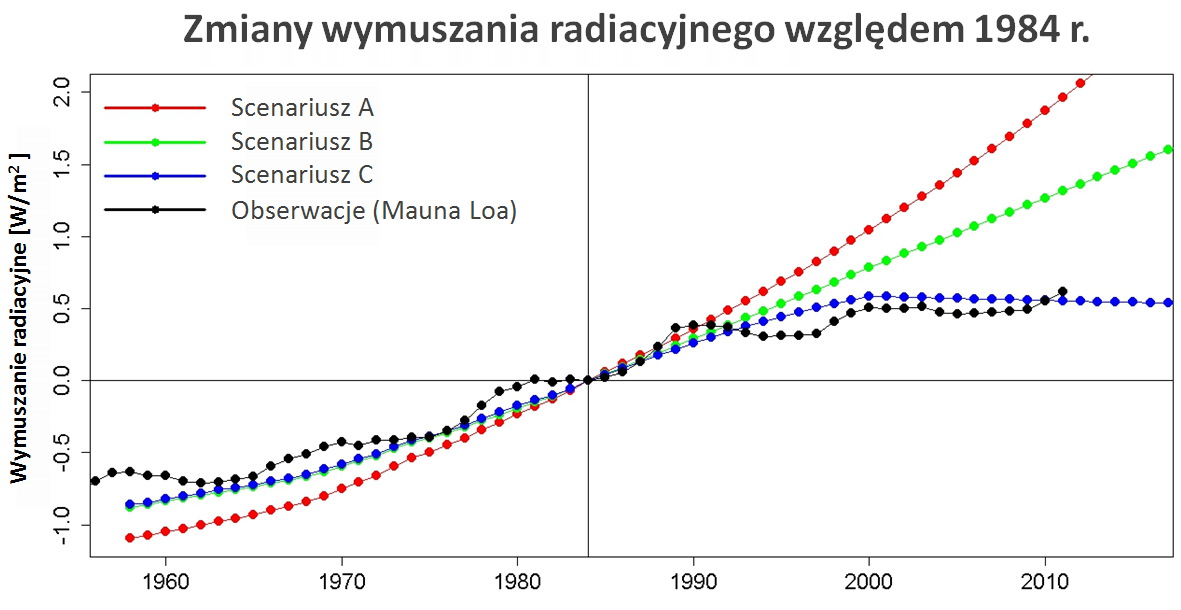

Oczywiście, o rzeczywistym wymuszaniu radiacyjnym nie decyduje ani sam dwutlenek węgla, ani metan czy freon, tylko suma wszystkich czynników. Przyjrzyjmy się więc sumarycznemu wymuszaniu radiacyjnemu, także z uwzględnieniem zmian czynników naturalnych (z wyłączeniem nieprzewidywalnych wulkanów) i porównajmy je ze scenariuszami Hansena.

Rzeczywiste wymuszanie radiacyjne w dobrym przybliżeniu odpowiada Scenariuszowi C. Powinniśmy więc oczekiwać, że obserwowana temperatura będzie zbliżona do tej uzyskanej w Scenariuszu C. I tak jest w istocie.

Czułość klimatu

Zgodność obserwowanej temperatury z prognozami Scenariusza C sprzed ponad ćwierć wieku jest bardzo wysoka. Tak wysoka, że aż trudno uwierzyć, że wynika po prostu z wysokiej jakości modelu – w sporym stopniu zakrawa wręcz na kwestię przypadku. Głosy krytyki „sceptyków”, że prognoza była spektakularną klapą modeli klimatycznych, są zupełnie niezrozumiałe.

Wysoka zgodność prognozy z rzeczywistością jest tym bardziej intrygująca, że model użyty do jej przygotowania zakładał czułość klimatu (zmianę temperatury powierzchni w odpowiedzi na podwojenie ilości CO2 w atmosferze) równą 4,2°C. To wartość leżąca w górnym zakresie prawdopodobieństwa obecnie przyjmowanej czułości klimatu (w granicach 1,5-4,5°C, z najbardziej prawdopodobną wartością 3°C).

Ostatnio pojawia się sporo opracowań prowadzących do wniosku, że czułość klimatu może leżeć właśnie w górnym zakresie szacunków. Zgodność prognozy Hansena z obserwacjami też to sugeruje.

Warto też zauważyć, że prognoza Hansena jest niewspółmiernie bliższa rzeczywistości, niż prognozy sceptyków przepowiadających brak wzrostu temperatury lub nawet ochłodzenie klimatu.

Ocieplenie w różnych regionach Ziemi

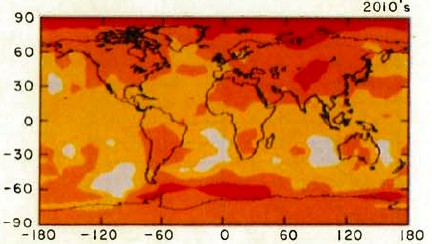

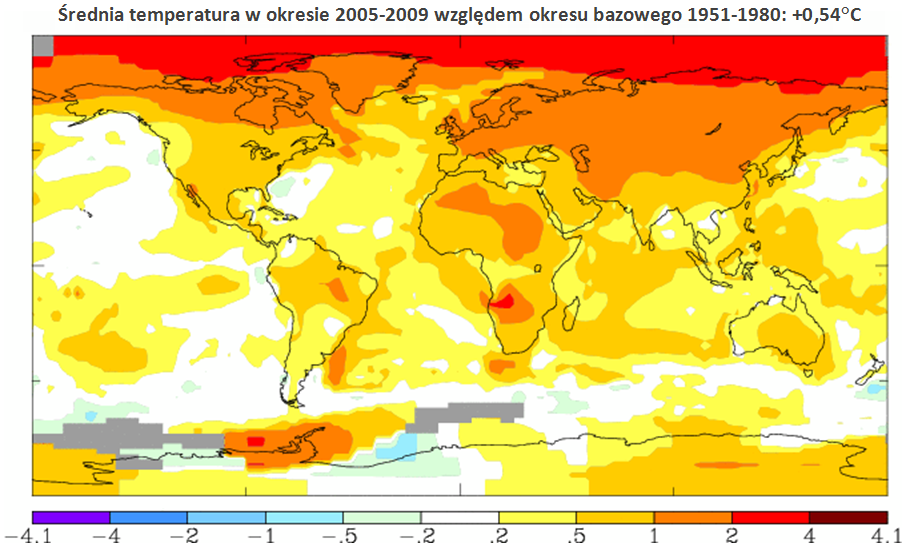

Oprócz samego wzrostu temperatury, Hansen prognozował także, jakie będzie ocieplenie w różnych regionach Ziemi w Scenariuszu B w latach 80. i 90. XX w. i w drugim dziesięcioleciu XXI w., a także, jak wzrośnie częstotliwość fal upałów. Jak sprawdziły się te prognozy?

Druga dekada XXI wieku dopiero się zaczęła, jednak możemy już dokonać porównania prognozy z obserwacjami. Zgodnie z przewidywaniami Hansena największe ocieplenie odnotowujemy w Arktyce, widzimy też plamy ciepła w północnej i południowej Afryce, zachodniej Antarktydzie i wyraźne ocieplenie na obszarze mas lądowych północnej półkuli. Jednym słowem – charakterystyka geograficzna obserwowanego ocieplenia jest zgodna z prognozą z 1988 roku.

Prognoza ekstremów temperaturowych (fal upałów)

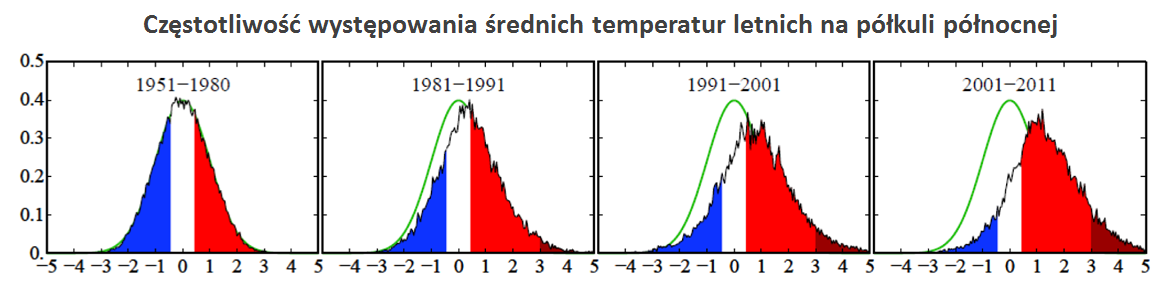

W pracy z 1988 roku Hansen przedstawił klimat z okresu 1951-1980 w formie kostki z dwoma ściankami w kolorze czerwonym (ciepła pora roku), dwoma w kolorze niebieskim (zimna pora roku) i dwoma w kolorze białym (temperatury bliskie średniej). Prawdopodobieństwo „wypadnięcia” każdej ścianki było identyczne (1/6), czyli prawdopodobieństwa wystąpienia okresu ciepłego, zimnego i neutralnego były takie same (1/3). Zgodnie z symulacjami ze Scenariusza B w drugiej dekadzie XXI wieku cztery z sześciu ścianek powinny być czerwone. To znaczy, że prawdopodobieństwo wystąpienia wyjątkowo ciepłych pór roku miało się podwoić – miały występować nie raz na trzy, lecz dwa razy na trzy lata.

Ćwierć wieku po opublikowaniu tej prognozy możliwa jest jej weryfikacja. Została ona przeprowadzona i opublikowana w artykule z 2012 roku. Cytując:

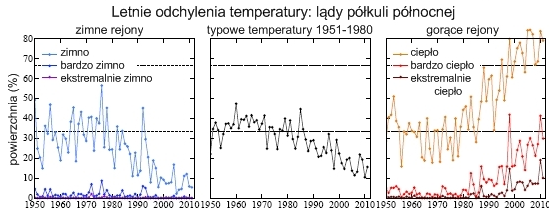

„Rozkład anomalii temperatur poszczególnych pór roku przesunął się w górę, a jego szerokość wzrosła. Istotną zmianą jest pojawienie się nowej kategorii letnich ekstremalnych fal upałów (z temperaturami przekraczającymi średnią z okresu 1951-1980 o ponad 3 odchylenia standardowe – 3σ), dotychczas praktycznie nie występującej. Takie ekstrema zdarzały się dawniej na obszarach obejmujących znacznie mniej, niż 1% powierzchni Ziemi, obecnie ich obszar obejmuje 10% powierzchni lądów.

Średnie temperatury pór roku w ostatnich trzech dekadach zmieniły się dramatycznie. Globalne przesunięcie rozkładu prawdopodobieństwa temperatur przekroczyło już jedno odchylenie standardowe, a nad lądami przesunięcie to jest jeszcze większe. Ponadto rozkład prawdopodobieństwa temperatur rozszerza się, powodując jeszcze częstsze wstępowanie wyjątkowo wysokich temperatur.

Temperatury pór roku zdefiniowane jako „niskie” w okresie 1951-1980 (średnia temperatura poniżej -0.43σ), które zdarzały się wtedy z prawdopodobieństwem 33%, wciąż spotyka się nad lądami z prawdopodobieństwem 10%. A więc chłodne zimy nie są dowodem na brak ocieplania się klimatu. Temperatury latem są obarczone mniejszą zmiennością niż zimą, szanse na to, że letnie temperatury trafią do kategorii „ciepło” z okresu 1951-1980 wynoszą już około 80%.

‘Kostka klimatyczna’ jest obecnie dociążona wystarczająco, by spostrzegawcze osoby (żyjące na tyle długo, by pamiętać klimat z okresu 1951-1980) mogły zaobserwować zmianę klimatu.

Najważniejszą zmianą „kostki klimatycznej” jest pojawienie się nowej kategorii ekstremalnie gorących anomalii letnich, ze średnią temperaturą przekraczającą tę z okresu 1951-1980 o ponad trzy odchylenia standardowe. Tak ekstremalne warunki przytrafiały się średnio w roku co najwyżej na kilku promilach powierzchni lądów. W ostatnich latach występują one na około 10% terenów lądów. Taki wzrost częstości występowania ekstremalnych anomalii pozwala nam z dużym stopniem pewności stwierdzić, że takie zdarzenia, jak ekstremalne fale upałów w rejonie Moskwy w 2010 roku czy Teksasie w 2011 roku, są konsekwencją postępującego globalnego ocieplenia. Rahmstorf i Coumou (2011), stosując bardziej wyrafinowane metody analizy fali upałów w Rosji, doszli do podobnych wniosków.

Dokładność prognoz Hansena

Prognozy Hansena dobrze bronią się w konfrontacji z rzeczywistością. Trafnie został przewidziany nie tylko średni wzrost temperatury powierzchni Ziemi, ale też zmiany wymuszania radiacyjnego, charakterystyka geograficzna ocieplenia oraz częstotliwości fal upałów.

Marcin Popkiewicz, konsultacja merytoryczna: prof. Szymon P. Malinowski

Fajnie, że tu jesteś. Mamy nadzieję, że nasz artykuł pomógł Ci poszerzyć lub ugruntować wiedzę.

Nie wiem, czy wiesz, ale naukaoklimacie.pl to projekt non-profit. Tworzymy go my, czyli ludzie, którzy chcą dzielić się wiedzą i pomagać w zrozumieniu zmian klimatu. Taki projekt to dla nas duża radość i satysfakcja. Ale też regularne koszty. Jeśli chcesz pomóc w utrzymaniu i rozwoju strony, przekaż nam darowiznę w dowolnej wysokości