MIT

To może być największe oszustwo naukowe wykryte w historii – NASA i NOAA zostały złapane na gorącym uczynku, zmieniając historyczne dane temperatury by wyprodukować „narrację zmiany klimatu”, która przeczy rzeczywistości. (…) [K]iedy urząd przejął Obama i zaczął popychać narrację o globalnym ociepleniu w celach politycznych, NASA musiała zmienić historyczne dane, żeby odwrócić tendencję chłodzącą i zamiast tego pokazać trend ocieplający.

Dokonano tego, wykorzystując komputery modelujące klimat, które szybko sfabrykowały dane, które chcieli widzieć badacze, zamiast tego co faktycznie miało miejsce w realnym świecie. (…) [D]ane historyczne, zwłaszcza upały i susze w latach 1930, teraz są systematycznie tłumione by wyglądały na chłodniejsze niż faktycznie były. Jednocześnie dane temp. od 1970 do 2010 są bardzo przesadzone by wyglądały cieplejsze niż były. (źródło: Wolna Polska, korekta językowa: redakcja NoK)

STANOWISKO NAUKI

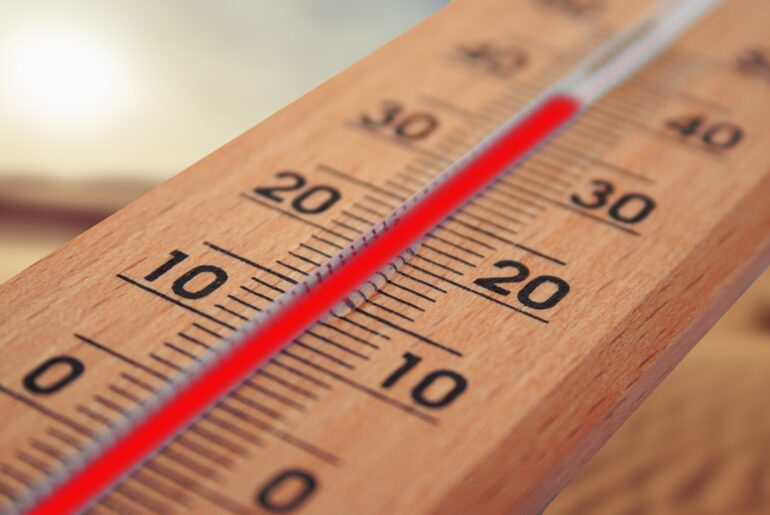

Rzekome fałszerstwo w rzeczywistości było korektą pomiarów temperatur maksymalnych i minimalnych, które była pierwotnie odczytywane w różnych porach dnia i przez to bezpośrednio nieporównywalne. Sama procedura korygująca jest jawna, opublikowana wiele lat temu i możliwa do odtworzenia przez każdego.

Większość danych dotyczących zmian klimatu na lądach z ostatnich 200 lat pochodzi z pomiarów wykonywanych przez stacje i posterunki meteorologiczne. Choć to nieocenione i bogate źródło informacji, pomiary te przeprowadzano raczej z myślą o raportowaniu aktualnych warunków meteorologicznych, a nie monitorowaniu długoterminowych trendów klimatycznych. Ponieważ dane pozyskane w ten sposób zawierają wpływ licznych czynników pozaklimatycznych (zwanych niehomogenicznościami), w analizach klimatologicznych nie powinno się używać ich w postaci „surowej”.

Przykłady czynników wpływających na jakość danych

Niektóre z tych niehomogeniczności to zwykłe błędy, wynikające z zawodności sprzętu albo ludzkich pomyłek. Przykładowo, osoba spisująca wartość z termometru mogła źle odczytać cyfry na skali; mogła zapisać je w nieczytelny sposób; mogła zapomnieć dodać znak 'minus’ albo symbol ten znak kodujący; mogła użyć nieodpowiedniej skali (Celsjusza, Kelwina czy Fahrenheita) przy raportowaniu danych. Błędy takie stosunkowo łatwo jest wyłapać i poprawić.

Jako przykład można podać średnie temperatury miesięczne mierzone w mieście Bilma, w Nigerii. W latach trzydziestych i czterdziestych XX wieku wiele stacji we francuskich koloniach w Afryce Zachodniej podawało temperaturę w kelwinach; później ktoś „poprawił” te wartości dzieląc je przez 10 (ponieważ błędnie założył, że 292 to zapis odpowiadający 29,2 stopni Celsjusza.

Inne niehomogeniczności związane są z samą aparaturą pomiarową oraz otoczeniem i mikroklimatem stacji. Rzadko zdarza się, by pomiary parametrów meteorologicznych były wykonywane dzisiaj dokładnie w tych samych warunkach i przy pomocy tych samych przyrządów co 100 czy nawet 50 lat temu. Niektóre stacje mogły zostać, w przeciągu dekad swojego funkcjonowania, otoczone przez teren zurbanizowany; inne wręcz przeciwne – przeniesione z przedmieść na tereny niezabudowane. Ponieważ temperatura atmosfery spada wraz z wysokością, wystarczy, by wysokość nad poziomem morza nowej lokalizacji różniła się o 100 metrów, żeby spowodować sztuczne ochłodzenie albo ocieplenie o wartości około pół stopnia. Również wymiana aparatury pomiarowej, klatki meteorologicznej czy nawet wycięcie okolicznych krzewów może wpływać na zmierzone przez stację wartości temperatury.

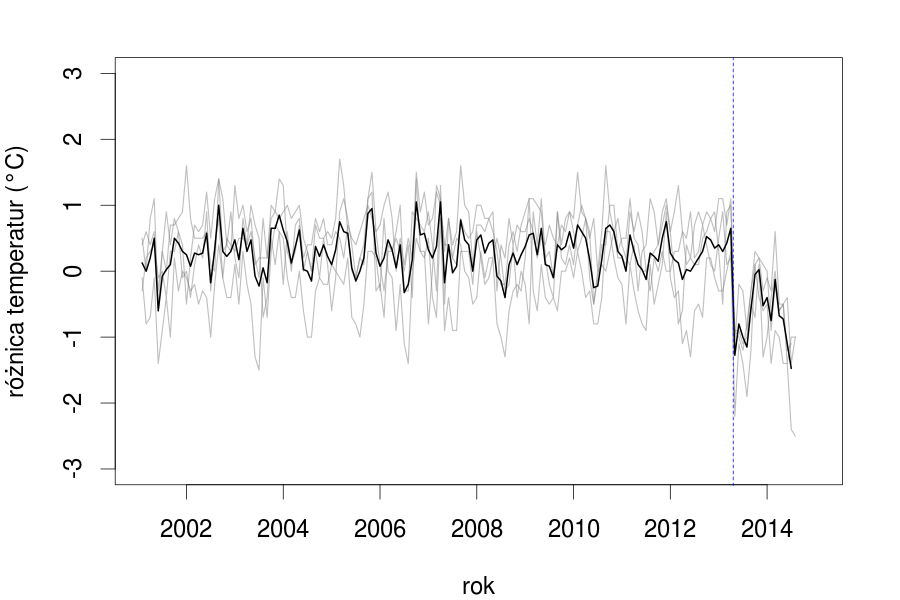

Przykład: w kwietniu 2013 roku IMGW przeniosło stację klimatyczną z Elbląga do Milejowa, do lokalizacji położonej 149 metrów wyżej nad poziomem morza. Porównując pochodzące z niej dane z pomiarami wykonanymi w okolicznych stacjach łatwo można dostrzec że spowodowało to znaczące obniżenie raportowanych wartości temperatury. Wykres poniżej pokazuje różnice w miesięcznych odczytach pomiędzy w Elblągiem a Kaliningradem, Olsztynem, Chojnicami i Toruniem (szary), oraz średnią różnicę pomiędzy tymi stacjami (czarny).

Jak naukowcy korygują błędy w danych

Na szczęście wykrycie niehomogeniczności w szeregu danych klimatycznych nie jest takie trudne. Błędy prowadzące do absurdalnych wartości można łatwo wyłapać, zmiany w oprzyrządowaniu czy metodach pomiarowych albo lokalizacji stacji są zwykle dokumentowane, a wpływ pozostałych nieklimatycznych czynników można znaleźć przy pomocy analizy statystycznej. Ponieważ pole anomalii temperatury ma niewiele przestrzennych stopni swobody (co oznacza, że pomiary dokonane w różnych lokalizacjach, oddalonych od siebie o dziesiątki a nawet setki kilometrów są ze sobą wysoce skorelowane) i jednocześnie jest nadpróbkowane (bo wiele państw na świecie ma gęstą sieć stacji i posterunków meteorologicznych), porównując wyniki pomiarów z pobliskich stacji można wykryć, które z danych nie pasują do reszty. Większość niehomogeniczności ma charakter raczej przypadkowy i nie występuje jednocześnie we wszystkich stacjach meteorologicznych. Jeśli zaś taka sytuacja ma miejsce (bo np. zarządzeniem centralnej agencji meteorologicznej zmienia się metoda pomiaru albo raportowania danych), to również nie ma problemu z jej wykryciem, gdyż jest dobrze udokumentowana.

Surowe dane i statystyka

Jeśli uda się nam znaleźć niehomogeniczności w serii danych klimatycznych, co można z tym zrobić? Sceptycy klimatyczni często domagają się, by używać tylko „surowych” danych, jednak jeśli dane te zawierają oczywiste błędy wymóg ten staje się absurdalny. Inni sceptycy twierdzą, że niehomogeniczności w danych klimatycznych oznaczają, że nie jesteśmy w stanie stwierdzić nawet, czy Ziemia ociepliła się w ciągu ostatnich 100 lat – ale ponownie jest to argument nie mający wiele wspólnego z rzeczywistością – jeśli średnia temperatura lipca rejestrowana przez stację podawana jest jako 18°C, a rok później 290,2°C, to nie oznacza to że niepewność związana z szacowaniem miesięcznej wartości średniej wynosi kilkaset stopni Celsjusza, lecz że najprawdopodobniej dokonano wymiany oprzyrządowania pomiarowego i obecne wartości podawane są w kelwinach. A ponieważ hipotezę tę można łatwo zweryfikować i ponownie skalibrować obserwacje tak, by były porównywalne z wcześniejszymi, rzeczywista niepewność związana z pomiarami jest trzy rzędy wielkości mniejsza, niż sugerowałyby to „surowe” dane.

Nie możemy cofnąć się w czasie i wykonać jeszcze raz, tym razem bezbłędnie, pomiarów, ani zapobiec przenosinom stacji meteorologicznych i wymiany oprzyrządowania. Na szczęście te same metody statystyczne, przy pomocy których można wykryć wpływ czynników nieklimatycznych, pozwalają też na oszacowanie ich wielkości, a zatem i ich usunięcie. Tego typu procedury nazywamy homogenizacją danych.

Choć w niewielkiej skali homogenizację można przeprowadzać „ręcznie”, już przy średniej wielkości kraju (a tym bardziej w skali całego kontynentu albo globu) jest to niemożliwe – dlatego wiele instytucji i grup badawczych zajmujących się badaniem klimatu opracowało zautomatyzowane algorytmy homogenizujące dane. Z testów tych algorytmów na syntetycznych danych wiemy, że choć nie są (bo być nie mogą) w 100% skuteczne, to znacząco zmniejszają ilość błędów i redukują niepewności związane z pomiarami.

Kontrowersje i ich przyczyny

Oskarżenia o fałszowanie danych dotyczą amerykańskiej Narodowej Administracji ds. Oceanów i Atmosfery (NOAA). NOAA zarządza jedną z trzech globalnych baz danych klimatycznych GHCN (Global Historical Climatology Network), do której trafiają dane wysyłane przez służby meteorologiczne poszczególnych państwa świata. Dodatkowo, dane pochodzące z okresu sprzed powstania globalnej sieci telekomunikacyjnej zostały skompilowane z papierowych roczników statystycznych i depesz, też dostarczanych przez poszczególne państwa. Sfałszowanie tych danych wymagałoby więc współpracy meteorologów i klimatologów z całego świata.

Otrzymane dane NOAA homogenizuje za pomocą zautomatyzowanego algorytmu zwanego PHA. Sam algorytm jest publicznie dostępny, podobnie jak dane wejściowe i wyjściowe – każdy więc może zajrzeć do środka, uruchomić i sprawdzić, że jego działanie nie jest „motywowane politycznie”. W przypadku danych globalnych, średni wpływ homogenizacji jest zresztą bliski zeru – bo w skali całej planety i tysięcy stacji meteorologicznych z całego świata większość błędów i niehomogeniczności ma charakter losowy, i równie dobrze może prowadzić do zawyżenia, jak i zaniżenia raportowanej przez daną stację temperatury.

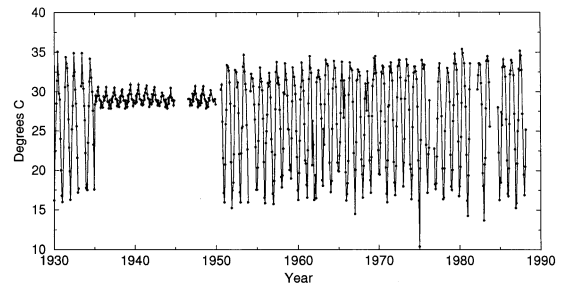

Inaczej jest w przypadku danych amerykańskich. Oficjalna analiza NOAA opiera się o historyczną sieć stacji klimatycznych US HCN. W przeszłości wiele z tych stacji pomiarowych było obsługiwanych przez ochotników, wykorzystujących do pomiaru temperatury tzw. termometr Sixa. Termometr taki zaznacza, przy pomocy popychanych przez słupek rtęci metalowych cylindrów, maksymalną i minimalną temperaturę osiągniętą w danym okresie; w momencie odczytu temperatury znaczniki muszą być „resetowane” i przesuwane z powrotem do pozycji odpowiadających aktualnej temperaturze.

Odczyt z termometru i jego reset dokonywany był przez obserwatorów co 24 godziny. Ponieważ jednak wymagało to interwencji człowieka, ze względu na wygodę operatorów nie odbywało się to o północy, lecz w ciągu dnia – i przez większość XX wieku było to popołudnie.

Wyobraźmy sobie teraz sytuację, że jednego letniego dnia temperatura maksymalna zostaje osiągnięta o godzinie 15 i wynosi 29 stopni Celsjusza, jest odczytywana przez obserwatora o godzinie 17, po czym następuje reset termometru. Wciąż jest jeszcze ciepło, więc w momencie resetu temperatura wynosi 26 stopni i taka jest też początkowa pozycja markera.

Następnego dnia przychodzi ochłodzenie, i maksymalna temperatura 24 stopni zostaje osiągnięta o godzinie 14. Kiedy obserwator przychodzi o 17 odczytać temperaturę, wciąż widzi maksymalną wartość z ostatnich 24 godzin, czyli poprzedniego dnia. Zapisuje zatem wczorajsze 26 stopni pod dzisiejszą datą. Widzimy zatem, że gdybyśmy teraz chcieli obliczyć średnią temperatury maksymalnej z kilku dni, zostanie ona zawyżona. Analogiczna sytuacja nastąpi, jeśli odczyt i reset termometru nastąpi o poranku – ale wtedy prowadzić to będzie do zaniżenia średniej temperatury minimalnej.

Przy monitorowaniu długoterminowych trendów klimatycznych nie miałoby to wielkiego znaczenia, bo ich wartości (czyli zmiana temperatury w jednostce czasu) byłyby bardzo podobnie niezależnie od tego, o której godzinie dokonywany był odczyt termometru. Problem pojawia się dopiero w momencie zmiany godziny odczytu – co miało miejsce w przypadku stacji amerykańskich.

Jak się okazuje, jeszcze do lat połowy lat sześćdziesiątych ubiegłego wieku zdecydowana większość obserwatorów dokonywała odczytu temperatur po południu. Potem zaczęło się to zmieniać na rzecz obserwacji dokonywanych o poranku, i obecnie proporcje się odwróciły. Ponieważ obserwacje prowadzone po południu zawyżają średnie temperatury maksymalne (a więc średnia temperatura zostaje zawyżona), a obserwacje poranne zaniżają średnie temperatury minimalne (a więc średnia temperatura zostaje zaniżona), skutkiem zmiany czasu obserwacji z godzin popołudniowych na przedpołudniowe jest zaniżenie średniej temperatury dobowej.

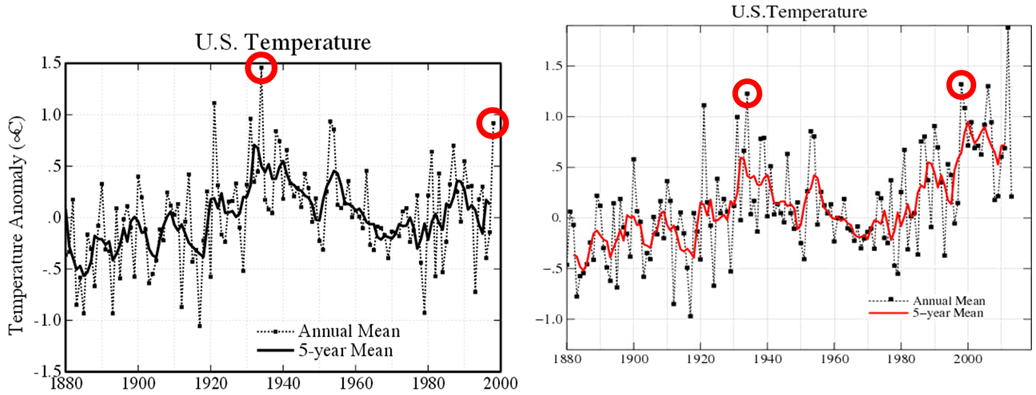

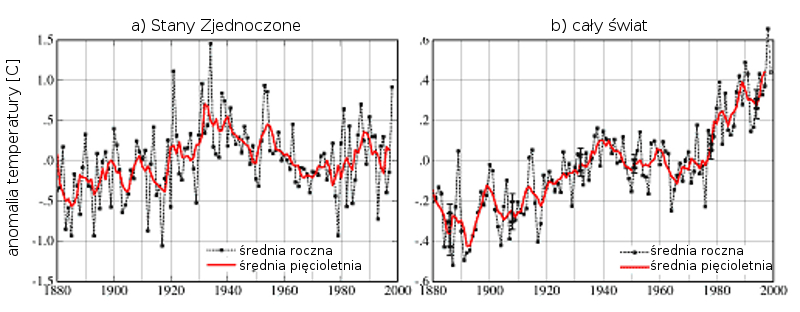

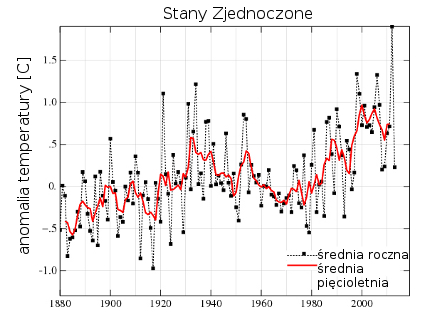

Nie ma wątpliwości, że ten efekt, zwany TOB (Time of Observation Bias), jest realny i ma rzeczywisty wpływ na raportowane średnie temperatury w skali całego USA. Jego istnienie można łatwo zweryfikować biorąc dane godzinowe z jakiejś stacji i obliczyć temperatury maksymalne i minimalne tak, jakby były mierzone przez termometr Sixa. Na szczęście efekt TOB, podobnie jak inne niehomogeniczności, można usunąć technikami statystycznymi z danych, rekonstruując je do postaci, w której zmiana czasu obserwacji nie miała miejsca. Efekt wprowadzenia poprawek obejrzeć można na wykresach poniżej. Jak widać, nawet przed przeprowadzeniem homogenizacji globalny trend temperatury był rosnący – problem z czasami pomiaru w Stanach Zjednoczonych nie miał na niego wielkiego wpływu.

Wracając do oskarżeń o „największe wykryte kiedykolwiek oszustwo naukowe” ze strony NASA i NOAA…

Prawdą jest, że dane zostały zmienione celowo. Nie było jednak potrzeby łapania nikogo na gorącym uczynku – kiedy klimatolodzy z NASA w 2001 roku (a zatem na początku pierwszej kadencji Georga W. Busha, a nie Baracka Obamy) zaczęli wykorzystywać poprawki NOAA korygujące efekt zmiany czasu obserwacji (czego nie robili jeszcze w roku 1999), po prostu napisali o tym w artykule naukowym, szczegółowo raportując, co zmienili w swojej analizie, dlaczego i z jakim skutkiem.

Jeśli ktoś z jakiegoś powodu nie ufa analizie NOAA (choć każdy możne sprawdzić, jak działa algorytm PHA), może skorzystać z analizy niezależnej grupy z Berkeley, która wykorzystuje zupełnie inną technikę homogenizacji – z podobnymi rezultatami. Ocieplenie pokazują też satelitarne pomiary dolnej warstwy atmosfery, które w ogóle nie mają nic wspólnego ze stacjami meteorologicznymi oraz obserwacje szeregu zjawisk, od topnienia lodowców, przez wzrost poziomu morza i zanik lodów Arktyki po przesuwanie się granic występowania roślin w kierunku biegunów i wiele innych.

Tezę, że „faktyczne dane pokazują trend chłodzący, a nie ocieplający” można zatem też włożyć między bajki.

Co jest dość intrygujące, osoby zaprzeczające zmianie klimatu dezawuują wyniki pomiarów temperatury bazujące na surowych danych pomiarowych jako mające w sobie mnóstwo błędów systematycznych. Kiedy zaś naukowcy dokonują homogenizacji danych i korekt na błędy systematyczne, spotykają się z medialnymi zarzutami komputerowej fabrykacji danych. Może „sceptykom klimatycznym” chodzi więc prostu o to, żeby siać wątpliwości w mediach?

Materiały dodatkowe

- o pomiarach ogólnie: https://www.stat.washington.edu/peter/593/Trewin.pdf

- o homogenizacji: https://www.clim-past.net/8/89/2012/cp-8-89-2012.pdf

- o TOBS: https://journals.ametsoc.org/doi/pdf/10.1175/1520-0450%281986%29025%3C0145%3AAMTETT%3E2.0.CO%3B2

- o PHA: https://www.ncdc.noaa.gov/oa/climate/research/ushcn/

- o US HCN: https://journals.ametsoc.org/doi/pdf/10.1175/2008BAMS2613.1

- oba artykuły Hansena: Hansen i in. (1999), Hansen i in. (2001)

Doskonale Szare, konsultacja merytoryczna: prof. Szymon P. Malinowski

Fajnie, że tu jesteś. Mamy nadzieję, że nasz artykuł pomógł Ci poszerzyć lub ugruntować wiedzę.

Nie wiem, czy wiesz, ale naukaoklimacie.pl to projekt non-profit. Tworzymy go my, czyli ludzie, którzy chcą dzielić się wiedzą i pomagać w zrozumieniu zmian klimatu. Taki projekt to dla nas duża radość i satysfakcja. Ale też regularne koszty. Jeśli chcesz pomóc w utrzymaniu i rozwoju strony, przekaż nam darowiznę w dowolnej wysokości