Na pewno słyszeliście wielokrotnie, że nie da się jednoznacznie obarczyć zmiany klimatu winą za konkretny huragan, ulewę czy suszę. Nie znaczy to jednak, że związek między tymi zjawiskami nie istnieje. Wraz z rosnącą średnią temperaturą powierzchni Ziemi niektóre ze zjawisk ekstremalnych stają się coraz częstsze lub coraz bardziej intensywne – mówimy, że zmienia się ich statystyka (prawdopodobieństwo wystąpienia oraz średnie cechy – np. temperatura, prędkość wiatru czy zasięg zalania). I możemy to opisać. W tym tekście objaśniamy, na czym polega atrybucja zjawisk ekstremalnych.

Naukowcy (a także decydenci czy towarzystwa ubezpieczeniowe) chcieliby jednak czegoś więcej. Już od wielu lat rozwijana jest w związku z tym metodologia pozwalająca odpowiedzieć, w ilu procentach zmiana klimatu odpowiada za konkretne zdarzenie lub związane z nim straty. Procedurę tę nazywamy z angielskiego „atrybucją”.

Naukowcy z National Oceanic and Atmospheric Administration od 2011 roku uczestniczą corocznie w przygotowywaniu specjalnego wydania biuletynu American Meteorological Society z opracowaniami dotyczącymi mających ostatnio miejsce zjawisk ekstremalnych. Z ich udziałem NOAA przygotowała zbiór informacji na temat atrybucji zjawisk ekstremalnych, na którym oparliśmy poniższy tekst.

Czym jest atrybucja zjawisk ekstremalnych?

Atrybucją nazywamy powiązanie konkretnego wydarzenia z czynnikami, które się na niego złożyły. Katastrofa – czy to naturalna czy związana z działalnością człowieka – ma na ogół więcej niż jedną przyczynę. W ramach atrybucji naukowcy odpowiadają na pytanie, czy spowodowane przez człowieka ocieplenie klimatu jest jedną z nich. Oceniają też (z coraz większą pewnością), w ilu procentach „odpowiedzialność” za zdarzenie ponosi antropogeniczna zmiana klimatu, a za jaką część odpowiada naturalna zmienność. Przypomina to orzekanie sądów lub specjalnych komisji o tym, na ile poszczególne osoby lub podmioty przyczyniły się do wypadku czy powstania szkód.

Po co rozwijać metody atrybucji?

Wiedza o tym, czy globalne ocieplenie przyczyniło się do zwiększenia częstości występowania lub intensywności zjawisk ekstremalnych, może pomóc narażonym na nie społecznościom w zabezpieczeniu się przed nimi na przyszłość. Przykładowo, znając prawdopodobieństwo powodzi i ich typowy zasięg można ocenić, czy i jakie instalacje przeciwpowodziowe opłaca się budować. Jeśli parametry te będą się zmieniać w związku z postępującą zmianą klimatu, należy to wziąć pod uwagę w planowaniu inwestycji i zagospodarowania przestrzeni w przyszłości.

Badania w dziedzinie atrybucji pozwalają na testowanie i doskonalenie modeli numerycznych opisujących różnego typu zjawiska ekstremalne. A lepsze modele dostarczają bardziej przydatnych informacji na przyszłość.

Możliwe również, że w przyszłości opracowania tego rodzaju pozwolą przygotować zestaw wytycznych, z których mogłyby korzystać sądy w sprawach wymagających ustalenia odpowiedzialności za szkody powstałe w wyniku zjawisk ekstremalnych, do których przyczyniło się globalne ocieplenie.

Czego możemy dowiedzieć się dzięki atrybucji?

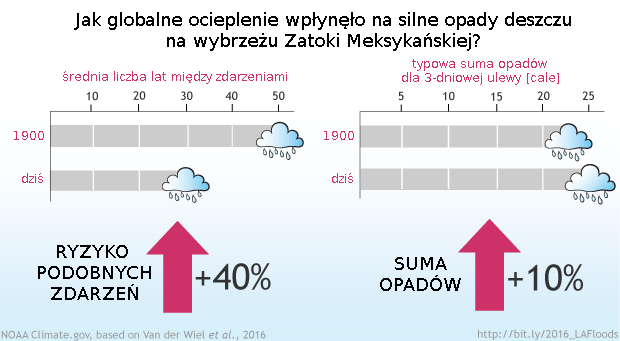

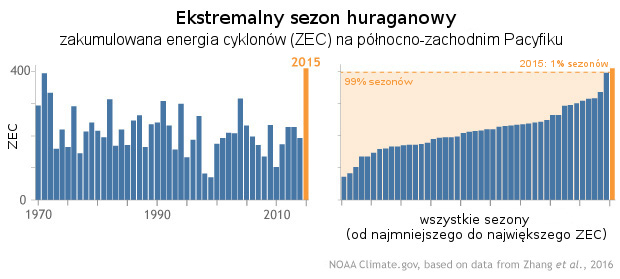

Zależnie od rodzaju analizy, badanie atrybucyjne może nam powiedzieć, czy globalne ocieplenie spowodowało (lub spowoduje), że zjawiska konkretnego typu są (lub będą) częstsze, niż w przypadku, gdybyśmy nie spowodowali globalnej zmiany klimatu. Możemy dowiedzieć się, jak zwiększyła się (lub zmniejszyła) przeciętna liczba lat pomiędzy kolejnymi tak intensywnymi zjawiskami, jakie jest prawdopodobieństwo wystąpienia określonego zjawiska oraz jak zmieniło się ono w związku z globalnym ociepleniem.

Czasami analiza atrybucyjna odpowiada również na pytanie, o ile globalne ocieplenie wpłynęło nie na prawdopodobieństwo wystąpienia zjawiska lecz na jego parametry, na przykład:

– jakie temperatury wystąpiłyby podczas fali upałów, gdyby koncentracja gazów cieplarnianych wciąż była taka jak w epoce przedprzemysłowej;

– o ile mniejsza byłaby suma opadu podczas „ulewy tysiąclecia”, gdyby wzrost temperatury nie spowodował wzrostu koncentracji pary wodnej w powietrzu;

– jak daleko w głąb lądu wlałyby się wody oceanu pchane przez huragan, gdyby średni poziom morza się nie podniósł.

Czego nie możemy dowiedzieć się dzięki atrybucji?

Analiza atrybucyjna nie powie nam czy globalne ocieplenie „spowodowało” konkretne wydarzenie. Gdy ludzie pytają, „czy wichurę na Pomorzu spowodowała zmiana klimatu?” chcieliby usłyszeć odpowiedź „tak” lub „nie”. Tymczasem takiej odpowiedzi nie można udzielić. Możemy powiedzieć, że globalne ocieplenie miało w zdarzeniu udział, że było jedną z przyczyn, ale nie jedyną czy dominującą (na razie).

Jak działa atrybucja zjawisk ekstremalnych?

Wiele analiz atrybucyjnych zaczyna się od ustalenia, dlaczego konkretne zdarzenie uznajemy za „ekstremalne”. Wybiera się konkretne kryterium (np. średnia temperatura dobowa podczas fali upałów albo prędkość wiatru utrzymywana przez co najmniej godzinę w huraganie) oraz wartość (konkretny próg temperatury, prędkości wiatru itp., który został przekroczony). Następnie sprawdza się w historii pomiarów, jak często wcześniej występowały podobne zjawiska. W większości opracowań używa się także modeli komputerowych, czyli programów prowadzących obliczenia z wykorzystaniem znanych i sprawdzonych praw fizyki (więcej o nich przeczytasz w tekście Wirtualny klimat). Możliwe są dwa ich zastosowania:

1. W połączeniu z historycznymi obserwacjami pogody oraz znanymi z pomiarów wymuszeniami klimatycznymi (takimi jak wzrost koncentracji gazów cieplarnianych) model klimatu pozwala stworzyć spójną historię zjawisk ekstremalnych od czasów, kiedy pomiary były sporadyczne, przez teraźniejszość aż po prognozy na przyszłość.

2. Z użyciem modelu klimatu można przeprowadzić doświadczenie niemożliwe do wykonania w rzeczywistości: prześledzić historię klimatu z uwzględnieniem zmierzonego wzrostu koncentracji gazów cieplarnianych oraz przy założeniu, że tego wzrostu nie było. Pozwala to na porównanie częstości zjawisk ekstremalnych w obu sytuacjach.

Jak eksperci definiują zjawisko ekstremalne?

Jednym ze sposobów na umieszczenie zjawiska ekstremalnego w szerszym kontekście jest utworzenie dla wybranego typu zjawiska „listy rankingowej” historycznych pomiarów – np. od najniższych do najwyższych temperatur zanotowanych w historii – i podzielenie tej listy na zakresy. Wyniki z samego początku i samego końca listy (np. najcieplejsze i najchłodniejsze 5%) uznawane są za ekstremalne.

Naukowcy mogą także określać niezwykłość zjawiska ekstremalnego w terminach „odchyleń standardowych” (potocznie nazywanych czasem σ „sigma”, bo ta grecka litera często jest używana jako ich oznaczenie). Odchylenie standardowe to termin statystyczny określający, na ile poszczególne wyniki pomiarów odbiegają od średniej z całego zbioru danych.

Wartość odchylenia standardowego mówi nam, jaki jest naturalny zakres zmienności wybranego parametru (np. temperatury czy sumy opadów). Jeśli wartości interesującej nas zmiennej układają się zgodnie z tzw. rozkładem normalnym (krzywa Gaussa), to w przedziale ±1σ od średniej znajduje się 68% przypadków, w przedziale ±2σ będzie 95,5% przypadków, a w przedziale ±3σ aż 99,7% przypadków (a więc po 0,15% będzie leżeć poniżej i powyżej przedziału ±3σ).

Gdy specjalista użyje w opisie ulewy określenia „3 sigma”, to ma na myśli, że suma opadu była o 3 odchylenia standardowe większa od średniej dla rozpatrywanego obszaru w wybranym okresie, czyli że prawdopodobieństwo tego zdarzenia wynosiło 0,15%. To daleko poza zakresem typowej zmienności.

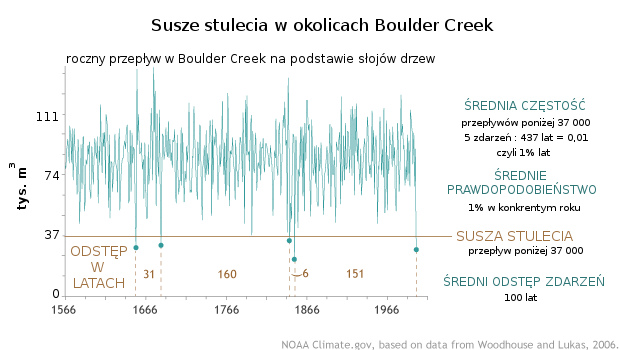

Innym sposobem na zdefiniowanie zjawiska ekstremalnego jest podanie prawdopodobieństwa, z jakim powinno wystąpić w okresie o wybranej długości lub inaczej – częstości występowania takich zjawisk czy czasu ponownego wystąpienia. To stąd biorą się określenia typu „powódź stulecia”, czyli „powódź takich rozmiarów, że występuje, średnio rzecz biorąc, raz na stulecie”.

Czy po powodzi stulecia jesteśmy bezpieczni przez kolejne 100 lat?

Niestety nie. „Powódź stulecia” czy „wichura dekady” to pojęcia związane ze statystyką. Mówią o tym jak często – średnio rzecz biorąc – zdarzają się zjawiska o określonym natężeniu. Inaczej mówiąc – o prawdopodobieństwie ich wystąpienia: w przypadku powodzi stulecia to prawdopodobieństwo dla każdego roku wynosi 1%, niezależnie od tego, kiedy ostatnio zdarzyła się podobna katastrofa.

Co więc oznacza „zjawisko stulecia”?

„Zjawisko stulecia” (ulewa, zima, powódź…) oznacza, że zjawisko jest na tyle ekstremalne, że prawdopodobieństwo jego wystąpienia w danym roku wynosi zaledwie 1% (wydarza się w jednym roku na 100). „Zjawisko tysiąclecia” oznacza, że prawdopodobieństwo podobnego zdarzenia to zaledwie 0,1%.

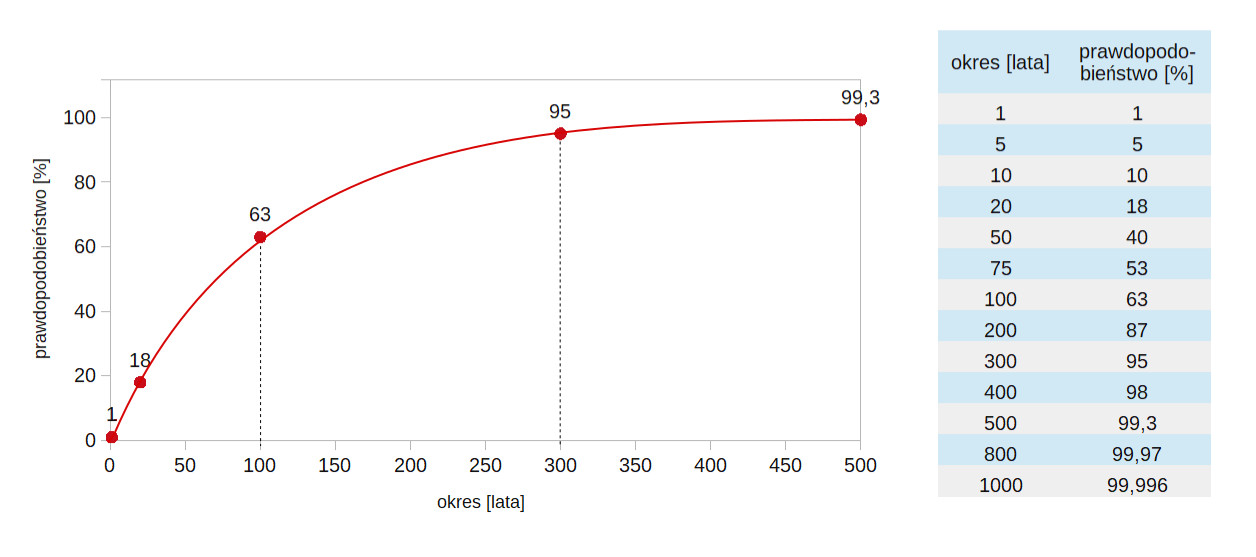

Prawdopodobieństwo, że „zjawisko stulecia” wydarzy się w konkretnym roku, wynosi 1% (na 99% – nie wystąpi). Jeśli jednak zastanawiamy się, gdzie pobudować dom albo jak wysoką barierę przeciwpowodziową postawić, interesuje nas nie tyle prawdopodobieństwo wystąpienia zjawiska w konkretnym roku, ile w ogóle w czasie użytkowania naszej inwestycji. Prawdopodobieństwo, że „zjawisko stulecia” wystąpi na przestrzeni konkretnego dwudziestolecia to już 18%, w ciągu pięćdziesięciu lat wystąpi na 40% a w ciągu stulecia – na 63%, czyli już z dość dużym prawdopodobieństwem.

Jak można wykryć zamiany w występowaniu zjawisk ekstremalnych?

Na ogół w ramach analizy atrybucyjnej dzieli się historię pomiarów (lub historię pomiarów uzupełnioną o obliczenia z użyciem modeli klimatu) na dwa lub więcej okresów, a następnie szuka się istotnych statystycznie różnic w występowaniu zjawisk ekstremalnych w okresach dawniejszych (kiedy wpływ człowieka na klimat był słabszy) i najnowszych.

Żeby sprawdzić zmianę w częstości występowania zjawisk, naukowcy mogą ustalić konkretny próg definiujący zjawisko ekstremalne – np. opady powyżej 50 cm w ciągu dwóch dni albo temperatury powyżej 20°C nocą przez trzy dni z rzędu – a następnie sprawdzić, ile razy coś takiego wydarzyło się w poszczególnych okresach.

Można też podejść do zagadnienia niejako na odwrót: zdefiniować zjawisko ekstremalne na podstawie częstości jego występowania, czyli np. „ekstremalnie suchymi” nazwać te 2% lat, w których wystąpiły najmniejsze sumy opadów. Następnie można sprawdzić, jakie parametry miały zjawiska kwalifikujące się do takich 2% na początku historii pomiarów i obecnie – na ile zmieniło się to, co uznajemy za ekstremum. Takie podejście jest użyteczne, gdy chcemy porównać ze sobą dane pochodzące z różnych obszarów – przykładowo, rok ekstremalnie suchy w rejonie tropikalnym będzie charakteryzował się zupełnie inną sumą opadów niż ekstremalnie suchy rok na Saharze.

Dlaczego do atrybucji potrzebujemy modeli numerycznych?

Dane pomiarowe mogą pokazać nam jedynie, czy w natężeniu czy częstości występowania zjawisk nastąpiła zauważalna zmiana, nie powiedzą nam jednak, co ją spowodowało. Badania trendów (np. wzrostu częstości występowania ulewnych opadów) sugerują, że przyczyną zmian jest globalne ocieplenie. Jednak dopiero dzięki modelowaniu numerycznemu (obliczeniom) można sprawdzić, czy z punktu widzenia fizyki takie powiązanie jest możliwe: czy wzrost koncentracji gazów cieplarnianych może właśnie w zaobserwowany sposób zmienić statystyki wybranego typu zjawisk.

Jedną z procedur pozwalających odpowiedzieć na to pytanie jest stworzenie dwóch wirtualnych światów, z których jeden odpowiada rzeczywistości jaką znamy – uwzględnia działalność człowieka i związane z nią emisje gazów cieplarnianych – a drugi, „alternatywny” to świat, w którym takie emisje nie nastąpiły. Ponieważ jedną różnicą w założeniach jest obecność (lub nie) czynnika ludzkiego, wiemy, że ewentualne różnice w statystykach klimatycznych (temperatury, opady, prawdopodobieństwo burz…) muszą wynikać właśnie z tego czynnika.

Dla tych dwóch konfiguracji modelu przeprowadza się setki lub tysiące symulacji – każda odpowiada jednemu z możliwych przebiegów wypadków. Dlaczego wiele opcji, a nie tylko dwie konkurencyjne? Aby poradzić sobie z tym, że nasze pomiary nie są dokładne i nie obejmują całej kuli ziemskiej. Upraszczając, prowadzimy obliczenia zakładając, że pomiary „były jakie były”, ale też „co by było, gdybyśmy akurat pomylili się o 1%, bo taką precyzję podał producent urządzenia pomiarowego”. Wyniki z wielu symulacji można uśrednić, można też sprawdzić ich rozrzut i inne statystyki.

Druga strategia polega na wykorzystaniu modeli do stworzenia bardziej kompletnej historii zjawisk ekstremalnych niż ta, którą zapewniają zapisy historyczne. Model, któremu podamy wszystkie dostępne dane pomiarowe i informacje o wymuszeniach klimatycznych może uzupełnić nasze obserwacje – np. określić, ile silnych burz powinno było przy danych warunkach wystąpić w rejonach, w których nie było stacji meteorologicznych. Otrzymujemy dzięki temu uzgodnioną, jednolitą historię zjawisk ekstremalnych od początku historii pomiarów do dziś. Pozwala nam to na zaobserwowanie zmian w częstości występowania i natężeniu zjawisk ekstremalnych.

Dlaczego niektóre ze zjawisk trudniej niż inne połączyć z globalnym ociepleniem?

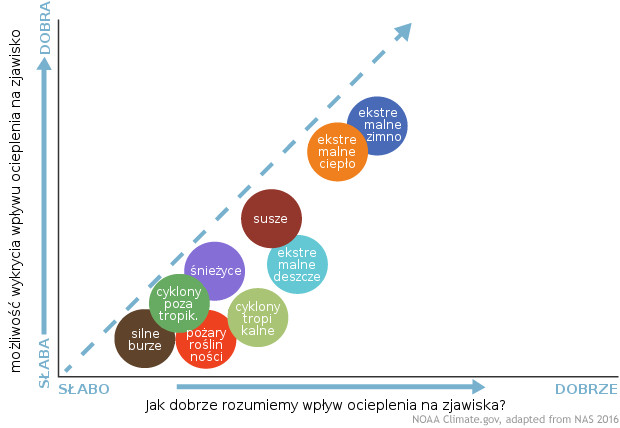

Jakość atrybucji wspiera się na trzech filarach:

– jakości danych obserwacyjnych,

– zdolności modeli do symulowania określonego typu zjawisk ekstremalnych,

– tego, na ile dobrze rozumiemy mechanizmy fizyczne prowadzące do wystąpienia zjawiska oraz jak wpływa na nie globalne ocieplenie.

W przypadkach, w których wszystkie trzy filary są solidne, otrzymujemy najpewniejsze wyniki. Jeśli jeden z filarów jest nieco słabszy, przeprowadzenie analizy atrybucyjnej staje się trudniejsze, a wyniki obarczone są większą niepewnością.

Generalnie z największa ufnością podchodzimy do analiz dotyczących wydarzeń związanych z występowaniem wysokich temperatur (fale upałów, rekordy gorąca, tropikalne noce). W ich przypadku serie pomiarowe są długie i dobrej jakości, modele sprawdzają się bardzo dobrze, a fizyka wiążąca globalne ocieplenie ze zmianami w ich występowaniu i natężeniu jest dobrze zrozumiana.

Dla odmiany, jeśli chodzi o występujące podczas silnych burz trąby powietrzne, analizy obciążone są większą niepewnością. Serie pomiarowe są stosunkowo krótkie i niespójne, a modele jeszcze niewystarczająco dobrze oddają tworzenie się tornad. Dodatkowo, mamy ograniczoną wiedzę na temat tego, jak zmiana klimatu odbije się na różnych zjawiskach atmosferycznych istotnych dla powstawania trąb (np. zmianach prędkości wiatru z wysokością).

A co jeśli dwie analizy nie zgadzają się co do tego, czy globalne ocieplenie miało znaczenie dla wystąpienia konkretnego zjawiska?

Taka sytuacja może czasami wynikać z błędów popełnionych przez jeden z zespołów analizujących zjawisko, zwykle jednak okazuje się, że różnica zdań jest pozorna i wynika z faktu, że naukowcy skoncentrowali się na innych aspektach zdarzenia lub inaczej zdefiniowali zjawisko ekstremalne.

W zależności od kryteriów wykorzystanych do uznania zjawiska za ekstremalne, rozmiaru branego pod uwagę obszaru, granic czasowych i innych czynników można dojść do różnych wniosków na temat tego samego wydarzenia. Przykładowo, „ekstremalną suszę” można zdefiniować na podstawie samych tylko sum opadów albo z uwzględnieniem wskaźników takich jak wilgotność gleby, na którą bezpośrednio wpływa także temperatura. Może także zdarzyć się, że w jednej z analiz oceniano siłę czy zasięg zjawiska, a w drugiej – prawdopodobieństwo wystąpienia podobnego zjawiska w wybranym okresie. Globalne ocieplenie może czynić dane zjawisko bardziej prawdopodobnym, ale nie silniejszym (lub na odwrót).

Czy jeśli analiza nie wykazała wpływu globalnego ocieplenia na konkretne zdarzenie, to jest on wykluczony?

Niekoniecznie. Może to wynikać z faktu, że dane historyczne są niewystarczające do przeprowadzenia rzetelnej statystyki. Albo z tego, że modele klimatu nie są w stanie wystarczająco realistycznie odtworzyć zjawiska. Może również zdarzyć się, że globalne ocieplenie wpłynęło na zjawisko w sposób inny niż ten objęty analizą. Przykładowo, w przypadku huraganu wkraczającego na ląd mamy do czynienia z rozmaitymi zagrożeniami: wiatrem, sztormowym wezbraniem morza, powodziami wynikającymi z silnych opadów, z których każde może ulec lub nie ulec modyfikacji w związku z globalnym ociepleniem. Pojedyncza analiza rzadko obejmować będzie wszystkie aspekty wydarzenia.

Skoro globalne ocieplenie doprowadziło do fundamentalnych zmian w całym systemie klimatycznym, to czy nie wpłynęło tym samym na każde zjawisko meteorologiczne?

Naukowcy różnie odpowiadają na to pytanie. Według niektórych, skoro wszystkie zjawiska zachodzą obecnie w cieplejszej i wilgotniejszej atmosferze, to wszystkie (ekstremalne i nieekstremalne) podlegają wpływowi globalnego ocieplenia. Inni uważają, że nie można patrzeć na sprawę w ten sposób. Używają analogii sportowej: powiedzmy, że kulomiot średnio 5 razy w sezonie pcha kulę na odległość 22 m, a następnie zaczyna przyjmować sterydy i osiąga ten wynik 8 razy w ciągu sezonu. Nie można twierdzić, że wszystkie sukcesy zawdzięcza sterydom, bo spodziewamy się, że nawet bez nich wciąż byłby w stanie osiągnąć wysokie wyniki, choć nie tak często. Podobnie nie możemy powiedzieć, że globalne ocieplenie stoi np. za wszystkimi burzami lub huraganami – jakaś ich liczba występowałaby i tak.

Wielu ekspertów zgadza się jednak, że tak ogólne pytanie jak „czy globalne ocieplenie wpłynęło na konkretne ekstremalne zjawisko pogodowe?” nie jest szczególnie ciekawe ani użyteczne. Użyteczna pod kątem naszego zrozumienia systemu klimatycznego i możliwości podejmowania racjonalnych decyzji jest odpowiedź na pytanie: „jak i w jakim stopniu zmiana klimatu przyłożyła się do konkretnego zdarzenia w konkretnym miejscu i czasie”. I tym właśnie zajmuje się analiza atrybucyjna.

Z jakimi przeszkodami mierzą się naukowcy zajmujący się atrybucją zjawisk ekstremalnych?

Podstawowym utrudnieniem jest fakt, że zjawiska ekstremalne są z definicji rzadkie, a dodatkowo nasze dane historyczne nie sięgają daleko w przeszłość. Dodatkowo, zjawiska meteorologiczne są zawsze wynikiem jednoczesnego działania wielu przyczyn. Ich zasięg często jest lokalny (np. w przypadku burzy), co utrudnia opisanie go w modelu klimatu (na temat problemów z reprezentacją zjawisk o niewielki zasięgu w modelach numerycznych piszemy bardziej szczegółowo w tekście Wirtualny klimat).

Analiza atrybucyjna polega na poszukiwaniu statystycznie istotnych różnic pomiędzy zjawiskami. Im mniej takich zjawisk zaobserwowaliśmy, tym większą niepewnością obarczone są wnioski.

Modele pozwalają naukowcom na zbudowanie wirtualnej kopii Ziemi i przeprowadzenie setek lub tysięcy eksperymentów – alternatywnych wersji historii (z osobnym zestawem zjawisk ekstremalnych w każdej z nich). Pomaga to zmniejszyć niepewność wyników analizy. Niestety, jeśli chodzi o symulowanie wpływu gazów cieplarnianych na zjawiska ekstremalne, globalne modele klimatu mają swoje specyficzne problemy. Przede wszystkim, zaprojektowane są tak, by przewidywały, jak w odpowiedzi na zmiany koncentracji gazów cieplarnianych zmieniać się będą średnie warunki meteorologiczne na dużych obszarach, gorzej zaś radzą sobie z pojedynczymi zjawiskami ekstremalnymi o lokalnym zasięgu.

Te ograniczenia powodują, że do przeprowadzenia analizy atrybucyjnej naukowcy muszą wykorzystywać modele o dużej rozdzielczości przestrzennej i czasowej. Niestety, im lepsza rozdzielczość modelu, tym więcej pamięci i mocy procesorów potrzeba na operowanie danymi, a w rezultacie przeprowadzenie symulacji wymaga więcej czasu. To ogranicza okres (liczbę lat), dla którego można przeprowadzić analizę oraz liczbę zmiennych – wyników symulacji – które można przechowywać. W miarę wzrostu mocy obliczeniowych komputerów i dostępności danych pomiarowych, dokładność analiz atrybucyjnych będzie rosła.

Aleksandra Kardaś na podst. Extreme event attribution: the climate versus weather blame game, NOAA, konsultacja merytoryczna: prof. Szymon P. Malinowski

Fajnie, że tu jesteś. Mamy nadzieję, że nasz artykuł pomógł Ci poszerzyć lub ugruntować wiedzę.

Nie wiem, czy wiesz, ale naukaoklimacie.pl to projekt non-profit. Tworzymy go my, czyli ludzie, którzy chcą dzielić się wiedzą i pomagać w zrozumieniu zmian klimatu. Taki projekt to dla nas duża radość i satysfakcja. Ale też regularne koszty. Jeśli chcesz pomóc w utrzymaniu i rozwoju strony, przekaż nam darowiznę w dowolnej wysokości