Stali czytelnicy naszej strony mieli już możliwość zauważyć, że istnieje więcej niż jedna „seria pomiarów średniej globalnej temperatury powierzchni Ziemi” (czytaj np. Zagadka trendu ocieplenia po 1998 roku). Część powstaje na podstawie pomiarów prowadzonych na powierzchni Ziemi (serie przygotowywane przez różne ośrodki różnią się metodami uśredniania, uzupełniania niedoborów danych itd.) a część – na podstawie pomiarów satelitarnych. Swego czasu niedopracowane wyniki pomiarów satelitarnych dostarczały pożywki osobom negującym dodatni trend zmian temperatury na Ziemi (Mit: Satelity nie pokazują ocieplania powierzchni Ziemi). Ponieważ temat ten regularnie powraca w dyskusjach, prezentujemy gościnnie tekst blogera Doskonale Szare, który wyjaśnia, co i jak właściwie mierzą satelity.

Metody teledetekcji

Istnieje kilka metod zdalnego (tzw. teledetekcja) pomiaru temperatury atmosfery.

Aktywne metody teledetekcji wykorzystują pomiar refrakcji (załamania) fal radiowych wysłanych przez statek kosmiczny przechodzących przez atmosferę. Technika ta z jest powodzeniem używana przy badaniu atmosfer innych planet, np. w ten właśnie sposób sonda New Horizons potwierdziła istnienie troposfery na Plutonie [1].

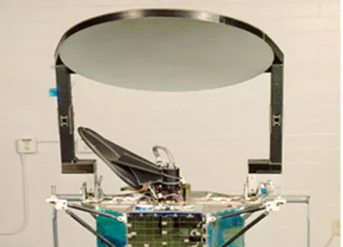

Na Ziemi meteorolodzy i klimatolodzy wykorzystują konstelację mniej więcej 30 satelitów sieci GPS, krążących wokół Ziemi na wysokości około 20 tys. kilometrów, z których emisji korzystają codziennie systemy nawigacji satelitarnej. Te same fale, po przejściu przez atmosferę, odbierane są przez krążące po niskiej orbicie amerykańsko-tajwańskie mikrosatelity programu COSMIC (a w przyszłości COSMIC-2, których wystrzelenie planowane jest na 2017 rok). Na podstawie zmian kierunku propagowania się fal radiowych w powietrzu możliwe jest odtworzenie jego temperatury albo wilgotności na ścieżce pomiędzy dwoma satelitami [2]. Wykorzystując naziemne staje odbioru sygnału GPS, możemy także określać profile temperatury i zawartości pary wodnej w atmosferze [3, 4].

Pasywne metody zdalnego pomiaru temperatury wykorzystują natomiast promieniowanie wysyłane przez samo powietrze – a dokładniej, mikrofale emitowane przez tlen. Ponieważ tlen jest dobrze wymieszany w atmosferze, a jego koncentracja zmienia się w znikomym zakresie, emisja promieniowania tlenu zależy głównie od jego temperatury. Starannie dobierając długość fali promieniowania rejestrowanego przez instrumenty satelity, można ograniczyć obserwacje tylko do określonego rejonu atmosfery.

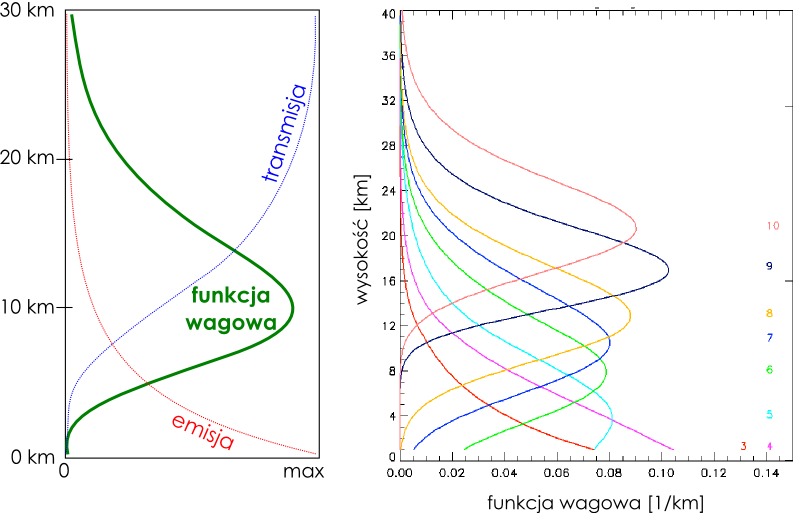

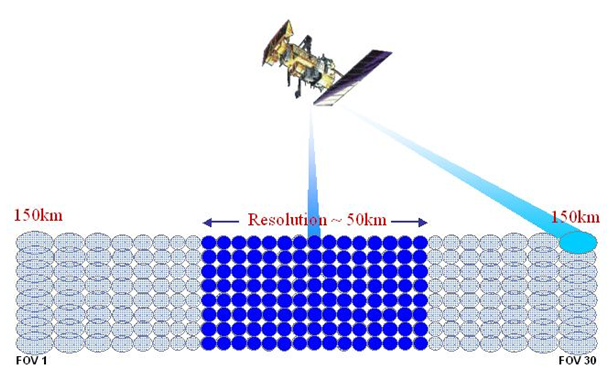

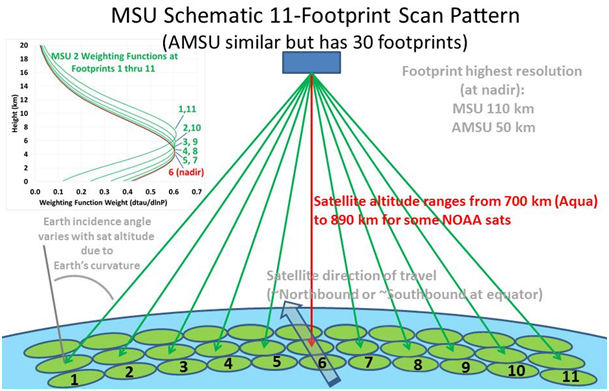

Każdy kanał instrumentu pomiarowego (długość rejestrowanej fali) ma swoją funkcję wagową. Funkcja wagowa mówi, na ile poszczególne piętra atmosfery „dokładają się” do wartości rejestrowanego sygnału, czyli na ile dobrze je „widać”. Przykładowo, kanał 5 radiometru AMSU-A mierzy promieniowanie o częstotliwości 53,6 GHz, którego emisja pochodzi w większości z najniższych warstw atmosfery – troposfery, z maksimum funkcji wagowej wypadającym w okolicach 4 km (patrz rysunek 2).

Jak widać, fotony rejestrowane przez dany kanał radiometru mogą pochodzić z warstw różniących się wysokością o wiele kilometrów (a więc i temperaturą). Wynika z tego, że zmierzenie temperatury atmosfery metodami teledetekcyjnymi nie jest rzeczą prostą. Jest to klasyczny przykład problemu zwanego w nauce zagadnieniem odwrotnym: próby wyznaczenia szukanego parametru (tutaj: temperatury różnych warstw atmosfery) na podstawie pomiaru wielkości, która od niego zależy (tutaj: promieniowania docierającego do satelity przelatującego nad atmosferą). Innymi słowy: na podstawie zliczenia liczby fotonów o określonej energii „wpadających w oczko” satelity staramy się określić co i w jakich warunkach te fotony wyemitowało.

Wiele zagadnień odwrotnych (w tym większość zagadnień w teledetekcji) jest tzw. problemami źle postawionymi. Nie, to nie jest niegrzeczna ocena pracy naukowców. To termin techniczny, oznaczający, że ten sam wynik pomiaru może pojawić się w różnych sytuacjach. W naszym przypadku różne parametry atmosfery (profile temperatury w połączeniu z profilami wilgotności i in.) mogą skutkować emisją promieniowania o nieodróżnialnych, z punktu widzenia czujnika wykonującego pomiar, własnościach.

Pierwsze próby

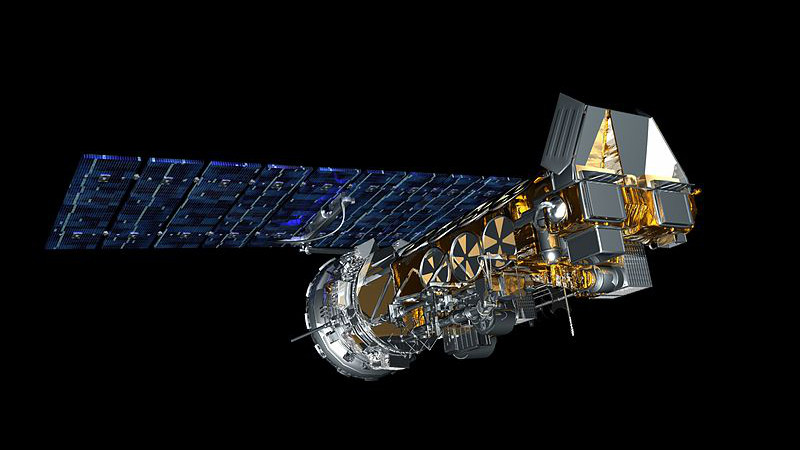

W 1990 roku dwóch naukowców NASA, Roy Spencer i John Christy, zaproponowało użycie pomiarów promieniowania mikrofalowego emitowanego przez atmosferę wykonanych przez radiometry MSU satelitów serii NOAA do zbadania globalnego ocieplenia, i przedstawili pierwszą satelitarną serię danych temperatury troposfery. Seria ta, popularnie określana akronimem UAH (od nazwy uniwersytetu gdzie zatrudniony był Christy – The University of Alabama in Huntsville), skonstruowana była w oparciu o tzw. temperaturę jasnościową (czyli temperaturę, jaką miałoby ciało doskonale czarne emitujące tyle samo promieniowania co obserwowany obiekt) zmierzoną na kanale 2 MSU (53,74 GHz).

Dzisiaj, ćwierć wieku później, oprócz UAH podobne serie temperatury atmosfery opracowują również zespoły RSS i NOAA STAR. Oryginalnej serii Spencera i Christy’ego odpowiadają dane oznaczane skrótem TMT (temperature in the middle troposphere), które są kombinacją temperatury jasnościowej mierzonej przez stare radiometry MSU (kanał 2) oraz, od roku 1998, nowsze AMSU-A (kanał 5).

W opublikowanym w tygodniku Science artykule [5] Spencer i Christy przekonywali, że precyzja pomiaru miesięcznych anomalii temperatury globalnej jest lepsza niż 0,01°C, a ze względu na możliwość obserwacji powierzchni całej planety oraz brak wpływu takich czynników jak np. efekt miejskiej wyspy ciepła, pomiary satelitarne znacznie lepiej nadają się do monitorowania globalnego ocieplenia niż tradycyjne analizy temperatury powierzchni globu.

Wnioski wyciągnięte przez Spencera i Christy’ego wzbudziły pewien sceptycyzm, bo dane satelitarne nie wskazywały na wzrost temperatury, przewidywany przez teorię antropogecznicznego globalnego ocieplenia [6] i obserwowany w pomiarach na powierzchni Ziemi.

Szybko okazało się, że rzeczywiście tezy na temat możliwości pomiarów satelitarnych były zdecydowanie zbyt optymistyczne, a w toku badań odkryto liczne problemy związane z metodami używanymi do wyznaczania trendów temperatur atmosfery. Nawet pobieżne omówienie tych badań to temat na grubą książkę, więc poniżej ograniczę się tylko do wymienienia najważniejszych problemów wraz z odniesieniem do podstawowej literatury przedmiotu.

1. „Temperatura troposfery” nie jest tylko temperaturą troposfery

Jak napisałem wyżej, funkcja wagowa kanału 5 AMSU-A (oraz kanału 2 MSU) obejmuje większość troposfery, z maksimum wypadającym w jej niskich warstwach. Okazuje się jednak, że część emisji mierzonej przez radiometr w tym zakresie widma pochodzi też z wyższych warstw atmosfery, czyli stratosfery. Zgodnie z teoretycznymi przewidywaniami stratosfera powinna się oziębiać wskutek niszczenia warstwy ozonowej przez związki chlorowcopochodne („freony”) oraz zwiększającej się koncentracji dwutlenku węgla. Ponieważ radiometr nie może odróżnić, czy zarejestrowany foton został wyemitowany przez ocieplającą się troposferę, czy oziębiającą się stratosferę, oba efekty nakładają się na siebie, zaniżając mierzone trendy temperatury.

W kolejnych wersjach swojej analizy temperatur (od wersji „B” z 1991 roku do wersji 5.6 z 2013 roku) Spencer i Christy próbowali obejść ten problem konstruując „syntetyczny” kanał 2RT, później nazwany 2LT, a jeszcze później TLT [7]. Kanał ten powstał jako kombinacja pomiarów wykonanych pod różnymi kątami, przez co możliwe było lepsze wyizolowanie emisji pochodzącej z dolnych warstw troposfery, i jak się wydawało usunięcie emisji stratosferycznej.

Metoda ta wprowadziła jednak kolejne problemy: znacząco zmniejszyła się precyzja pomiaru (zarówno jeśli chodzi o rozdzielczość przestrzenną, jak i stosunek sygnału do szumu w zmierzonej temperaturze jasnościowej), oraz powiększył się wkład emisji z powierzchni Ziemi w promieniowanie rejestrowane przez satelity. Szczególnie problematyczne okazały się być rejony polarne, gdzie dodatkowe zakłócenia powoduje obecność lodu [8].

W 2004 roku inny zespół naukowców zaproponował [9] alternatywną metodę konstrukcji syntetycznego kanału dla dolnej troposfery, opartą o kombinację dwóch różnych kanałów radiometru (2 i 4 MSU oraz 5 i 8 AMSU-A). Metoda ta została zastosowana w analizie RSS (firmy Remote Sensing Systems), a od ubiegłego roku zaczęli jej używać także Spencer i Christy (od wersji 6.0 analizy UAH [10]). Co charakterystyczne, zespół NOAA STAR, który też publikuje własną niezależną analizę danych satelitarnych, z opracowywania takiego syntetycznego kanału „dolnej troposfery” zrezygnował w ogóle, dochodząc do wniosku że jego przydatność jest niewielka w obliczu niepewności pomiarowych, jakimi byłby obciążony.

2. Serie pomiarowe nie są homogeniczne

… czyli wykorzystują dane różnego pochodzenia. Konstrukcja serii temperatur o długości wystarczającej by była przydatna w badaniach nad klimatem (czyli 20-30 lat) wymaga użycia danych z kilkunastu różnych satelitów, pracujących w różnym czasie i z różnym oprzyrządowaniem na pokładzie. Jak wspomniałem, analizy UAH, RSS i NOAA STAR używają zarówno pomiarów wykonanych przez starszy typ czterokanałowych radiometrów MSU, jak i nowszych, wciąż wykorzystywanych radiometrów AMSU. Ale nawet instrumenty tego samego typu, kalibrowane na Ziemi według tych samych wytycznych, zmieniają trochę parametry podczas montażu satelity i później w trakcie samej misji obserwacyjnej satelity, zależąc między innymi od jego własnej temperatury.

Na orbicie możliwości powtórnej kalibracji instrumentów satelity są ograniczone. W przypadku radiometrów pomiary temperatury jasnościowej atmosfery ziemskiej mogą być porównywane z temperaturą przestrzeni kosmicznej (czyli temperatury mikrofalowego promieniowania szczątkowego Wielkiego Wybuchu, wynoszącej 2,73 K), oraz temperaturą specjalnej płytki (mierzonej innymi metodami), jednak ekstrapolacja nieliniowej zależności pomiędzy rzeczywiście mierzonym przez radiometr sygnałem (przetworzoną na ciąg cyfr zmianą napięcia) a temperaturą, w oparciu o tylko dwa punkty danych nie jest wcale taka prosta. Przykładowo, jedną z nierozstrzygniętych kontrowersji jest poprawka zastosowana do kalibracji pomiarów satelity NOAA-9, która zdaniem klimatologów z University of Washington została przez Spencera i Christy’ego zastosowana niewłaściwie [11].

Kilka lat temu naukowcy z NOAA znaleźli sprytny sposób na wzajemną kalibrację instrumentów różnych satelitów, którym zdarzało się przelatywać w tym samym czasie nad tym samym punktem (co w przypadku orbit polarnych zdarza się w okolicach biegunów), i ten rodzaj kalibracji jest obecnie używany w analizie NOAA STAR [12].

Kolejnym bardzo poważnym problemem jest dryf orbit. Satelity meteorologiczne (a także szpiegowskie) zwykle krążą po orbitach polarnych, na których przelatują nad tymi samymi punktami na powierzchni Ziemi o tej samej godzinie czasu słonecznego. Można zrozumieć to oglądając poniższą animację:

W ciągu kilku-kilkunastu lat przebywania satelity na orbicie zwykle powoli dryfuje on w kierunku wschodnim albo zachodnim, przez co przelatuje on nad tym samym punktem w innym czasie (później albo wcześniej). Ponieważ temperatura atmosfery zmienia się w cyklu dobowym, zatem dwa pomiary wykonane w odstępie 10 lat, jeden na przykład wczesnym popołudniem, a drugi na przykład wieczorem, oprócz długoterminowego trendu klimatycznego będą też zawierać, zwykle znacznie większy, wkład dobowej zmiany temperatury.

Efekt dryfu orbity trzeba zatem uwzględnić i jakoś skompensować. Niestety, pierwsze wersje analizy Spencera i Christy’ego dryf ignorowały, a wersje późniejsze stosowały poprawkę dobową z niewłaściwym znakiem, przez co pogłębiały istnienie błędów systematycznych w trendach temperatur troposfery [13].

3. Temperatura troposfery nie jest tylko temperaturą powietrza.

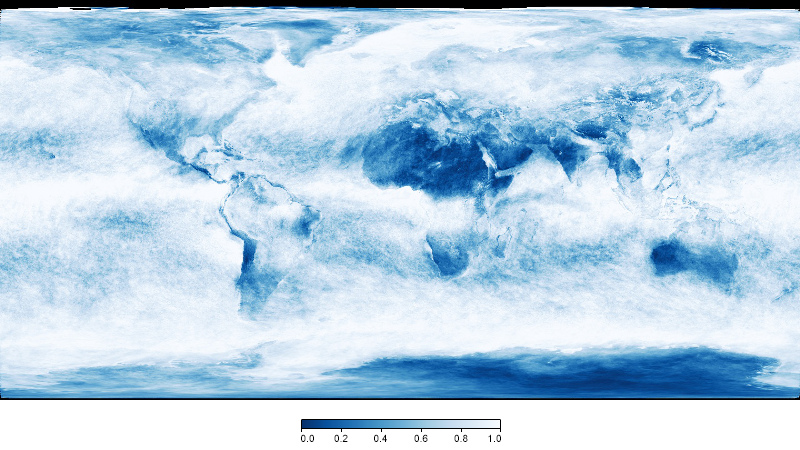

Teledetekcja temperatur oparta o promieniowanie mikrofalowe wydawała się atrakcyjna również dlatego, że pozwalała na badanie atmosfery niezależnie od obecności chmur, które zwykle zasłaniają dużą część powierzchni planety. Spencer i Christy w 1990 roku szacowali, że wpływ emisji z innych niż tlen składników atmosfery, oraz refrakcji mikrofal na cząsteczkach wody w chmurach i deszczu jest mniejszy niż 0,01°C w przypadku globalnych anomalii miesięcznych. Ostatnie badania [14] sugerują, że ignorowanie obecności chmur zaniża trendy zmian temperatur troposfery o 20-30%.

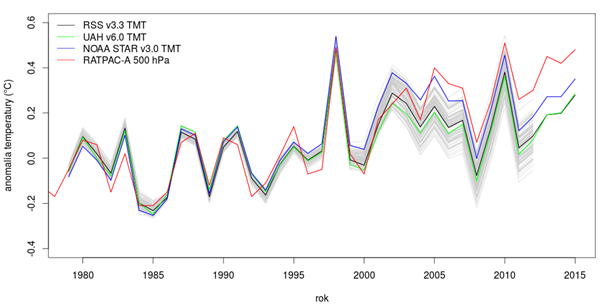

Wynika z tego, że określenie temperatury troposfery nie jest takie proste, jak się kiedyś wydawało, a satelitarne serie temperatury nie są lepszym wskaźnikiem globalnego ocieplenia niż zwykłe analizy temperatury powierzchni Ziemi, oparte o pomiary stacji meteorologicznych i temperatury oceanów. W 37-letniej serii temperatur TMT, opracowanej na podstawie tych samych danych wejściowych, trend liniowy wynosi zaledwie 0,07°C na dekadę w analizie UAH, 0,08°C na dekadę w analizie RSS, i 0,12°C na dekadę w analizie NOAA STAR – a jest to teoretycznie najprostszy produkt satelitarny, wykorzystujący tylko jeden kanał radiometru! Pokazuje to, że bez wyjaśnienia różnic pomiędzy różnymi analizami temperatur atmosfery trudno jest używać ich jako argumentu, że się ona nie ociepla (albo że się ociepla „mniej niż oczekiwano”).

Co z radiosondami?

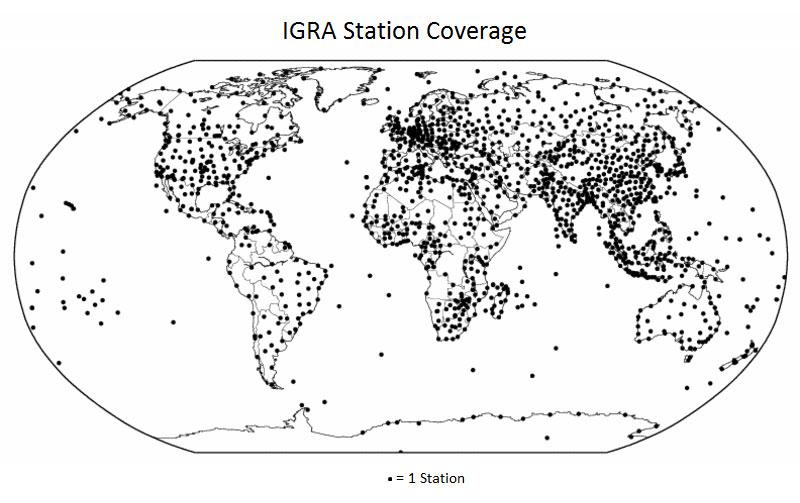

Radiosondy to małe urządzenia zawierające przyrządy mierzące ciśnienie, temperaturę, wilgotność i inne parametry atmosferyczne, unoszone w powietrzu przez balony meteorologiczne. Pomiary wykonywane w miarę wznoszenia i lotu balonu, aż do momentu jego pęknięcia w górnych warstwach atmosfery, są przesyłane drogą radiową do stacji naziemnych. Radiosondy światowej sieci pomiarów meteorologicznych WMO są wypuszczane w tym samym czasie, dwa razy na dobę (w okolicy północy i południa czasu Greenwich), z ponad 600 stacji na całym świecie, a uzyskane w ten sposób dane o stanie globalnej atmosfery zasilają modele numeryczne prognozujące pogodę.

Radiosondy umożliwiają zbadanie temperatury atmosfery z precyzją niemożliwą do uzyskania innymi metodami, jednak mają też i swoje wady. Globalna sieć pomiarowa jest z konieczności ograniczona głównie do lądów (oraz nielicznych oceanicznych wysepek), jej utrzymanie jest stosunkowo kosztowne, i podobnie jak w przypadku innych pomiarów wykonywanych w konkretnych lokalizacjach, dane zbierane przez radiosondy wymagają homogenizacji.

Mierzony przez radiosondy od 1958 roku długoterminowy trend temperatury globalnej wynosi 0,14°C na dekadę [15]. W tropikach jest nawet wyższy, i wynosi 0,25°C na dekadę [16]. Na szybkie ocieplanie się tropikalnej troposfery wskazuje również niedawno opublikowana analiza prędkości wiatrów [17].

Nie ma wątpliwości co do ocieplenie klimatu

Niezależnie od przyczyn rozbieżności pomiędzy różnymi analizami temperatur troposfery, samo ocieplenie klimatu nie jest już od dawna przyczyną kontrowersji w środowisku naukowym. O ile w 1990 roku nie były kompletnie nieprawdopodobne sugestie Christy’ego i Spencera, że analizy temperatur oparte o pomiary stacji meteorologicznych zawierają nieuwzględnione, duże błędy systematyczne (np. efekt miejskiej wyspy ciepła); to dzisiaj, ćwierć wieku później, nie ma wątpliwości że globalne ocieplenie nie jest tylko artefaktem pomiarowym.

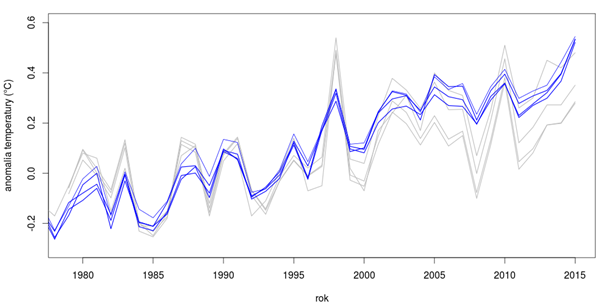

Dane dotyczące ocieplenia na powierzchni planety są obecnie precyzyjniejsze, niż analizy satelitarne. Łatwo może to zobrazować rozrzut wartości różnych serii temperatur, opracowywanych przez różne, niezależne zespoły naukowców:

O ociepleniu planety wiemy zresztą nie tylko dzięki stacjom meteorologicznym, ale także i pomiarom temperatur oceanów wykonanych przez statki i boje oceanograficzne; z szacunków tempa regresji lodowców; pomiarów temperatur podpowierzchniowych w odwiertach geologicznych i zmian temperatur wiecznej zmarzliny; analizom zmian zachowań sezonowych, zasięgów występowania różnych gatunków roślin i zwierząt oraz wielu innych niezależnych obserwacji.

Nie ma też wątpliwości co do przyczyn ocieplenia

Obserwowane zmiany klimatu są spójne z przewidywaniami teoretycznymi opartymi o znane od dziesięcioleci prawa fizyki. Zgodnie z tymi przewidywaniami, zwiększona koncentracja gazów cieplarnianych powinna doprowadzić do wzmocnienia efektu cieplarnianego, i ocieplenie powierzchni planety. Inne, teoretycznie możliwe przyczyny zmian klimatu (np. wahania aktywności słonecznej) pozostają wykluczone przez dane obserwacyjne.

[1] The Pluto system: Initial results from its exploration by New Horizons

[2] The COSMIC/FORMOSAT-3 Mission: Early Results

[3] Observing Earth’s atmosphere with radio occultation measurements using the Global Positioning System

[4] Climate intercomparison of GPS radio occultation, RS90/92 radiosondes and GRUAN from 2002 to 2013

[5] Precise Monitoring of Global Temperature Trends from Satellites

[6] Dzisiaj wiemy, że główną tego przyczyną była zbyt krótka, bo zaledwie 10-letnia, seria obserwacyjna którą dysponowali wtedy Spencer i Christy. Ze względu na relatywnie dużą, w stosunku do wartości (ówczesnego) trendu, zmienność międzymiesięczną i międzyroczną temperatury globalnej, w żadnej serii danych (czy to satelitarnych, czy to naziemnych) nie da się wyznaczyć istotnego statystycznie trendu dla okresu 1979-1988. Późniejsze, dłuższe satelitarne serie temperatur troposfery opracowane przez Spencera i Christy’ego też nie wskazywały ocieplenia, jednak tutaj większą rolę odegrały wprowadzone przez nich błędy w analizie danych.

[9] Satellite-derived vertical dependence of tropical tropospheric temperature trends; Contribution of stratospheric cooling to satellite-inferred tropospheric temperature trends

[10] Prace nad wersją 6 serii UAH rozpoczęła się w 2006 roku, niedługo po odkryciu błędów w zastosowaniu poprawek dobowych (o czym niżej), i została ona w końcu „opublikowana” na blogu Roya Spencera w roku 2015, z zastrzeżeniem, że to dopiero wersja „beta”. Nie wiadomo, kiedy i czy w ogóle planowana jest publikacja opisu metod analizy w recenzowanym czasopiśmie naukowym.

[11] A Bias in the Midtropospheric Channel Warm Target Factor on the NOAA-9 Microwave Sounding Unit

[12] Predicting Simultaneous Nadir Overpasses among Polar-Orbiting Meteorological Satellites for the Intersatellite Calibration of Radiometers; Recalibration of microwave sounding unit for climate studies using simultaneous nadir overpasses; Intersatellite calibration of AMSU-A observations for weather and climate applications

[13] The Effect of Diurnal Correction on Satellite-Derived Lower Tropospheric Temperature

[14] „Uncertainty of AMSU-A derived temperature trends in relationship with clouds and precipitation over ocean; 30-Year atmospheric temperature record derived by one-dimensional variational data assimilation of MSU/AMSU-A observations; Trends of MSU Brightness Temperature in the Middle Troposphere Simulated by CMIP5 Models and Their Sensitivity to Cloud Liquid Water

[15] BAMS State of the Climate in 2014, Global Climate

Fajnie, że tu jesteś. Mamy nadzieję, że nasz artykuł pomógł Ci poszerzyć lub ugruntować wiedzę.

Nie wiem, czy wiesz, ale naukaoklimacie.pl to projekt non-profit. Tworzymy go my, czyli ludzie, którzy chcą dzielić się wiedzą i pomagać w zrozumieniu zmian klimatu. Taki projekt to dla nas duża radość i satysfakcja. Ale też regularne koszty. Jeśli chcesz pomóc w utrzymaniu i rozwoju strony, przekaż nam darowiznę w dowolnej wysokości